即刻App年轻人的同好社区

下载

氢图海外版本Vivasnote已在Product Hunt发布,盼大家投票助力。

www.producthunt.com

氢图和Vivas精心设计的图谱嵌套结构,方便地用图形化的形式来收集灵感、整理创意、梳理思绪。

www.producthunt.com

氢图和Vivas精心设计的图谱嵌套结构,方便地用图形化的形式来收集灵感、整理创意、梳理思绪。

Just a moment...

10 02

OpenAI+微软智能语音,通过AI帮助你多场景练习英语沟通表达能力,听力、口语、词汇量、句式,加强英语表达的自信心!

超级好用的AI英语口语学习神器 - Timtalk 口语AI来啦!

16 12

也聊两句幕布的过往,16年四月开始和@晓力 一起创办幕布,幕布前两年的代码基本都出自我手,18年6月进入字节后,第一个半年,基本是我一个人在维护幕布,之后从北京转到深圳,花了两年时间和@遥行Gofurther 一起把团队艰辛拉扯到三四十人的规模,并复制出了飞书思维笔记项目,到我离开时,幕布已平稳过渡到字节体系。

论感情,没人任何人比我对幕布的感情深,没有人比我更了解它。

关于此次字节转让幕布,自去年10月份xmind发文提及幕布之时,我与@晓力 即开始与字节相关部门深入沟通,我们也尝试了各种可行方案,付出了非常多努力。

但是种种原因,字节投资部门后来选择了flomo,我也相信这会是一个好的选择。

至于没有能力将幕布回购,对我而言,遗憾很多,但祝福幕布!祝福@少楠Plidezus ,望后续一切顺利

论感情,没人任何人比我对幕布的感情深,没有人比我更了解它。

关于此次字节转让幕布,自去年10月份xmind发文提及幕布之时,我与@晓力 即开始与字节相关部门深入沟通,我们也尝试了各种可行方案,付出了非常多努力。

但是种种原因,字节投资部门后来选择了flomo,我也相信这会是一个好的选择。

至于没有能力将幕布回购,对我而言,遗憾很多,但祝福幕布!祝福@少楠Plidezus ,望后续一切顺利

287 4567

一分钟视频展示下aski.ai的作图功能,5种风格的文字生图,基于gfpgan的图形修复,基于ControlNet的图形重绘,在线5秒出图

00:55

33 610

Aski的AI绘画上线了,aski.ai,已支持移动端。

支持多种绘画任务,快速5秒内出图,对中文关键词友好,历史记录永久保存。

集成了8种优秀的绘画模型,大热的Stable Diffusion、Openjourney、ControlNet、Anything v4、GFPGAN图像修复模型等,无需本地显卡与部署,在线一键体验。

支持多种绘画任务,快速5秒内出图,对中文关键词友好,历史记录永久保存。

集成了8种优秀的绘画模型,大热的Stable Diffusion、Openjourney、ControlNet、Anything v4、GFPGAN图像修复模型等,无需本地显卡与部署,在线一键体验。

55 1034

聊一下 aski.ai 这种基础AI服务有没有利润,篇幅较长。

很多人只会去计算token,没错,gpt-3.5-turbo价格确实只有gpt-3的1/10,为0.002/1000 tokens,但更重要的是,他提供了上下文聊天的支持,就意味着,每次我们会把聊天的上文尽量多的提交给api,所以每个请求提交的数据会比以前gpt-3多很多。因为单次往返上限为4096tokens,所以提交的messages我们会控制在2000~3000tokens,留1000+的空间用于api的返回量。

所以开始聊天后,单次提问往返tokens数量会在3000~4000tokens之间。成本就是5分左右。

而Aski就是定价5分/提问,之前我们使用gpt-3的接口时,我们定价1分/提问,由于gpt-3的davinci模型价格很贵,单次提问光接口费用就大于1毛钱,所以我们是不可能有利润的。

此外,还要算上服务器的开销,在内容风控方面支出?那利润在哪呢?

Aski运行两个月,上个月基于davinci的模型,成本高,并且送的多,我们是亏损的。

很多类似的服务,声称免费服务,要么就背后做的模拟抓取(稳定性堪忧),要么是建立在白嫖OpenAI赠送的18美金账户的(做一堆免费账户)。

我们为保证服务稳定(尽量长期可用)这应该是健康的商业行为,我们是真实支付给OpenAI费用的。

同时我承认现在做的这些东西都太基础了,有一部分是出于我个人兴趣,以及AI带给我的惊喜,尽量参与其中做一些力所能及的产出,只希望能提供一些“正经”的工具,为行业健康贡献一点点力量。

同时也期望国内大厂早日做出ChatGPT这等优秀AI服务,并免费提供给每个普通人,那天既是我关闭Aski问答功能之日。

很多人只会去计算token,没错,gpt-3.5-turbo价格确实只有gpt-3的1/10,为0.002/1000 tokens,但更重要的是,他提供了上下文聊天的支持,就意味着,每次我们会把聊天的上文尽量多的提交给api,所以每个请求提交的数据会比以前gpt-3多很多。因为单次往返上限为4096tokens,所以提交的messages我们会控制在2000~3000tokens,留1000+的空间用于api的返回量。

所以开始聊天后,单次提问往返tokens数量会在3000~4000tokens之间。成本就是5分左右。

而Aski就是定价5分/提问,之前我们使用gpt-3的接口时,我们定价1分/提问,由于gpt-3的davinci模型价格很贵,单次提问光接口费用就大于1毛钱,所以我们是不可能有利润的。

此外,还要算上服务器的开销,在内容风控方面支出?那利润在哪呢?

Aski运行两个月,上个月基于davinci的模型,成本高,并且送的多,我们是亏损的。

很多类似的服务,声称免费服务,要么就背后做的模拟抓取(稳定性堪忧),要么是建立在白嫖OpenAI赠送的18美金账户的(做一堆免费账户)。

我们为保证服务稳定(尽量长期可用)这应该是健康的商业行为,我们是真实支付给OpenAI费用的。

同时我承认现在做的这些东西都太基础了,有一部分是出于我个人兴趣,以及AI带给我的惊喜,尽量参与其中做一些力所能及的产出,只希望能提供一些“正经”的工具,为行业健康贡献一点点力量。

同时也期望国内大厂早日做出ChatGPT这等优秀AI服务,并免费提供给每个普通人,那天既是我关闭Aski问答功能之日。

31 1731

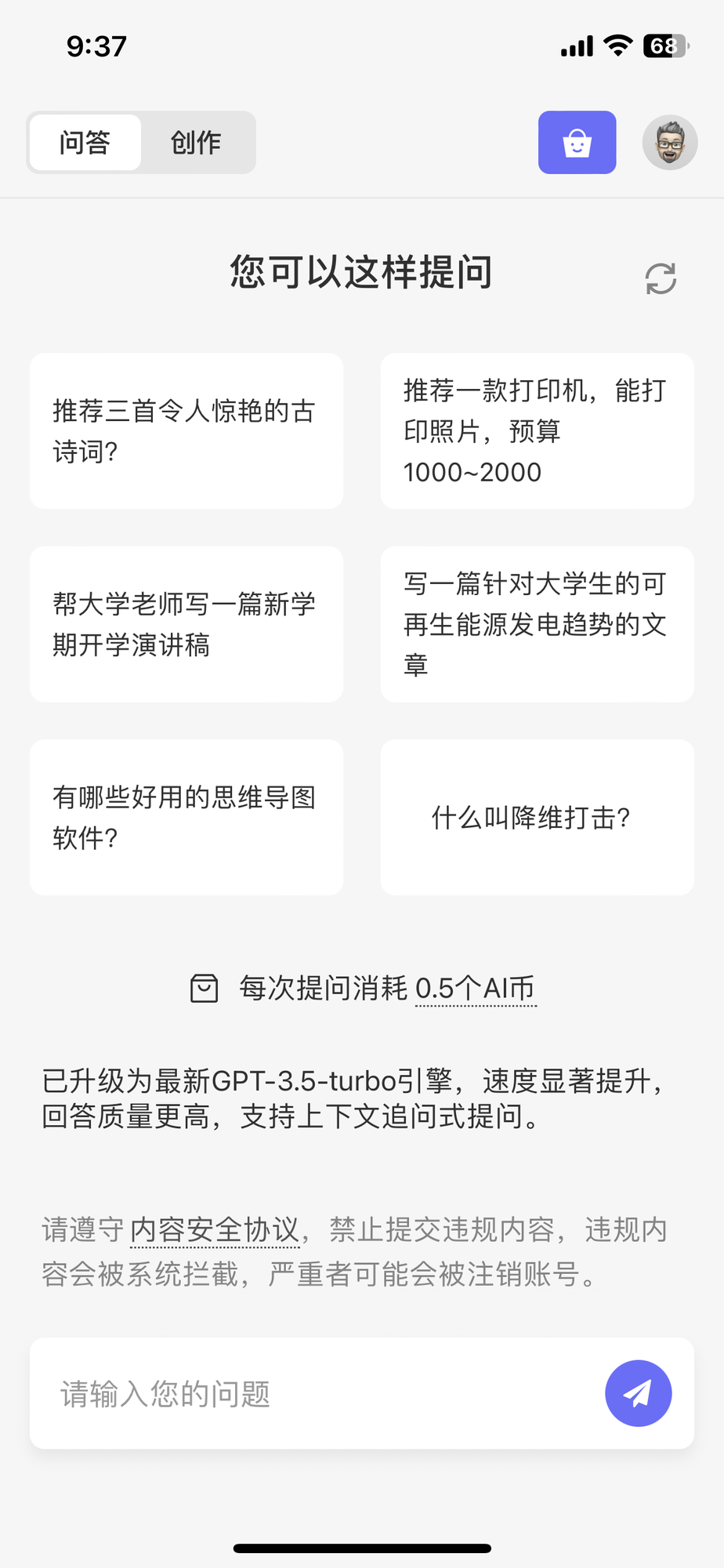

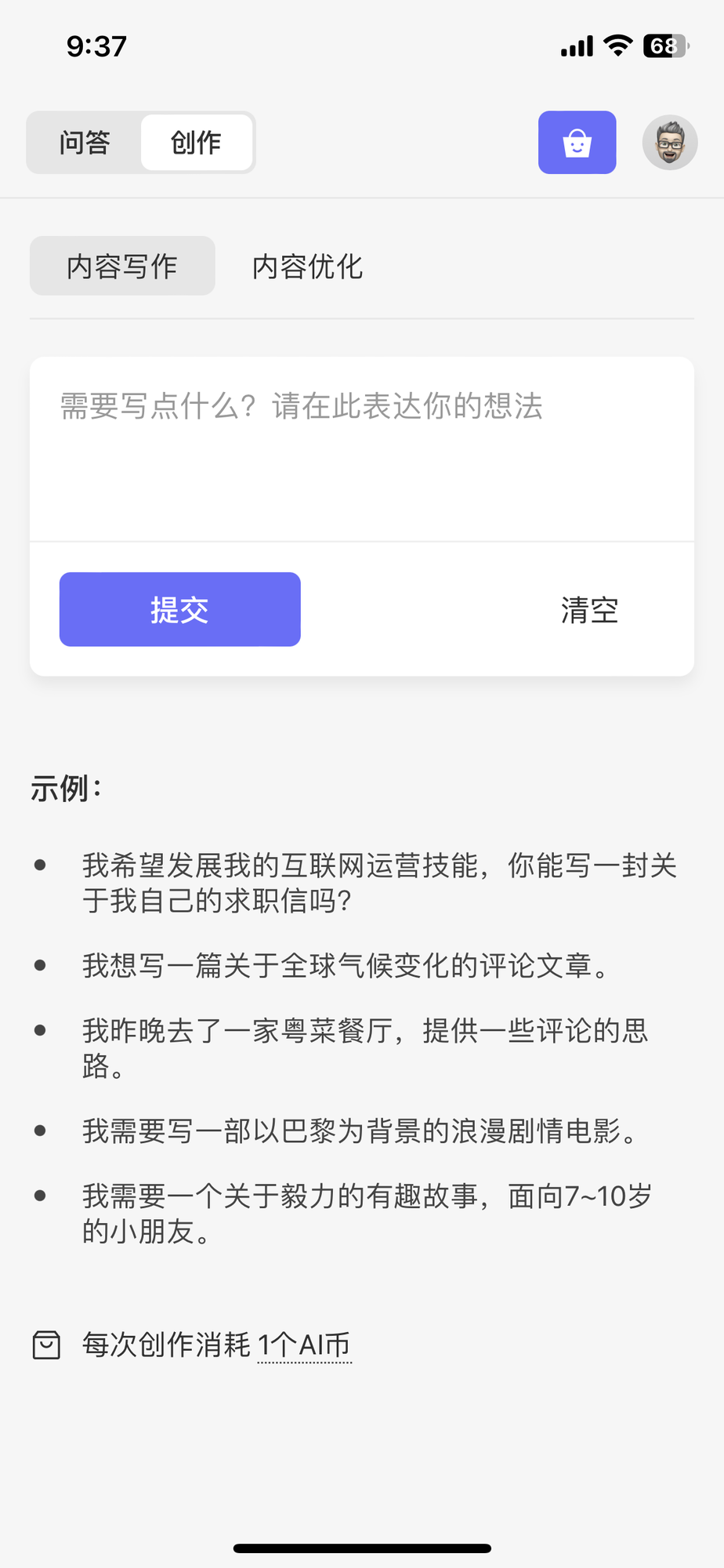

也分享一下我们的AI作品,aski.ai

聊天问答就不说了,gpt-3.5-turbo确实很turbo,大家用上都会快,未来会更快,可能连stream模式都不需要了。

我们设计了一个通用的创作工作流:

* AI内容生成,给定主题,要要求生成内容

* 对内容做微调,提出一个优化要求,告诉AI调整的方向,再继续tuning

网页版aski.ai和多端App可用

聊天问答就不说了,gpt-3.5-turbo确实很turbo,大家用上都会快,未来会更快,可能连stream模式都不需要了。

我们设计了一个通用的创作工作流:

* AI内容生成,给定主题,要要求生成内容

* 对内容做微调,提出一个优化要求,告诉AI调整的方向,再继续tuning

网页版aski.ai和多端App可用

47 1421

我们的 aski.ai 已经升级为OpenAI今天发布的gpt-3.5-turbo模型引擎,聊天响应速度极快,创作质量明显提升,并且也可支持基于上下文的追问式聊天。

Aski iOS版本也上线App Store了,iPhone,iPad都能获得不错的体验。

gpt-3.5-turbo是真的很棒!

Aski iOS版本也上线App Store了,iPhone,iPad都能获得不错的体验。

gpt-3.5-turbo是真的很棒!

Aski - 中文AI问答与创作

35 115