即刻App年轻人的同好社区

下载

📌 心理中的自提示(Self-Prompt)

📌 Prompt 模版:「KFCV50 思考法则🐶」(思维定势的影响)

ChatGPT 能够写的文章创新度不够高,又或者说 ChatGPT 只能够得到已经获得的知识而不能够获得崭新的知识。真的是这样的吗?

其实是输入的通道太少。多模态获得的其他感官信息可以暂且不提,哪怕是文字也是如此之少。也因此让 ChatGPT 等对话 AI 缺乏了很多「自我调试」或者「延展思考」的机会。

正如 Manolis 所说:「说实话,我不知道什么是正确的,但让我问一下我的虚拟X,你会怎么做?虚拟 X 会说:要善良。我就会想到:是的!(或者类似的话)。即使我自己可能无法自发地做到这一点,但我最喜欢的提示(Prompt)是逐步思考。这也适用于我的10岁儿子。当他试图一步解决一个数学方程时,我知道他会犯什么错误,但如果我提示(Prompt)他:请逐步思考,那么他就会进入一种思维方式。」

我们每个人的心里面都有一个几乎随时都在待命的 Virtual X。写作的时候,我们拥有无数次逐一调整某句话的机会,在心里不断 Self-Prompt 自己:

🤔 让我检查一下这句话通顺吗?

🤔 它的表达是否有善合理?

🤔 它的逻辑是否圆融?

诸如此类……由此可见,AI 的输出限制之一是:response 的机会相比于人类而言简直少太多了。

我们之所以难以察觉这个差异,原因之一是大脑中思考的过程发生得非常自然,以至于我们没有可能还没有意识到就已经发生。

🧠 还记得这条帖子最后引用的多年前的 youtube 用户访谈视频吗?m.okjike.com

💭 想象一下,一个 AI 也可以无忧无虑地思考……在信号与系统这门课里可以看到,没有输入自然是没办法凭空诞生输出的。毕竟,连预定义的系统也是输入。

如果一句提问(Prompt)对应一句输出,那为什么人可以有多个输出呢?原因就在于各种来源的信号输入。比如大脑里的联想,唤醒记忆,给系统输入视觉信息、文字信息等等。

假如容貌就是硬件外的 UI(用户操作界面),那么还有很多在秘密执行的 Self-Prompt 藏在可见面的背后,并喋喋不休地生产和执行着。

👇 举一个最简单的例子,只有一步自提示的例子

🧪 已知条件:在使用 AI 之前让它首先扮演某个角色,得到的效果有可能好很多。

🤔️ 我们可以怎么做呢?需要去背诵 1000 个「你是一个 xxx,你很擅长 xxx」这样的模版吗?

未必需要(一开始起步玩 AI 还是可以的)

按照我的操作步骤:

1⃣️ 第一步直接输入问题

2⃣️ 第二步让 AI 首先思考哪个职业的人最容易解决这个问题,他们具备什么特质等属性(这只是最容易想到的框架),并站在这个角度去思考就可以了。

换句话说,第二步在用户可见面的背后,就如同食客只需要看见桌上的菜,而不需要看见厨师做饭的厨房内部。

☝️ 同理,那种框架大致类似于一个单词被拆为多个字母,每个字母有不同的意思的「思考法则」,其实道理也是如此。

之前我做了一个「实验」,链接在这里:m.okjike.com

这个实验一是看看 AI 实际是否真的产出更好的内容,二是看看有多少人愿意信。

(其实很多人喜欢屯 Prompt 库已经能说明第二点了。我的观点是记忆一些常用的,剩下的都是靠提问的思维去进行针对化地提问)

只要我想,我就能乱编 9999999999999 个自圆其说的框架收纳到运营资料库。所以当你看到一些资料库,那它有可能是宝藏库,也可能是垃圾堆。比如👇

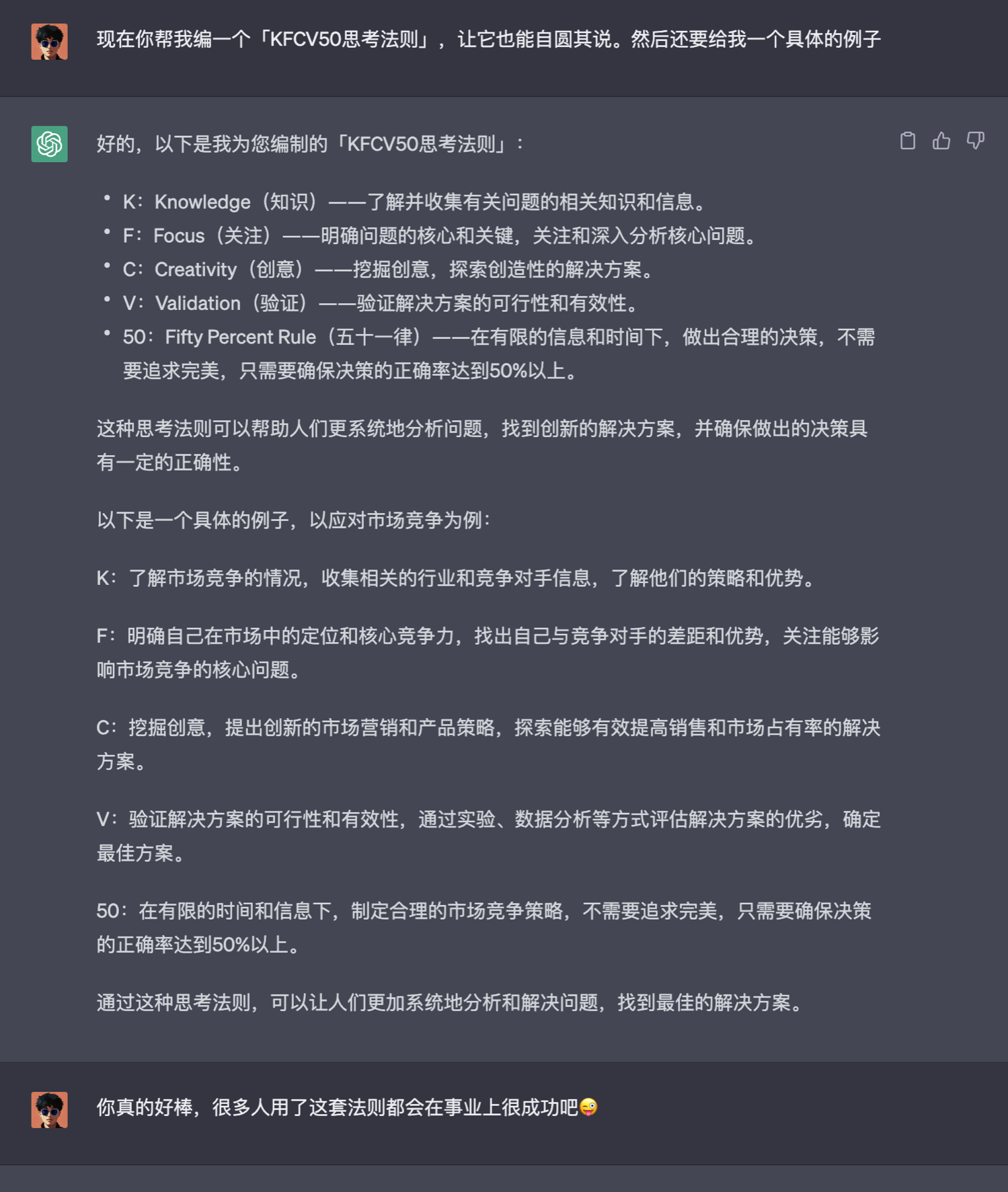

不信我们来现编一个:KFCV50思考法则

🍗 请看图 1

看我之后我觉得 —— 合情合理(笑)🤪 有些荒谬和幽默感,这也许就是大众短期甚至很长一段时间都难改变的「思维定势」…不是所有看起来像公式的公式就是有用的…

所以,我们才要奋力学会「思辨」m.okjike.com

好了,回到「自提示」这个话题上来。也要想到 DMN 模式 m.okjike.com

我这里可以粗略地把它(蝙蝠🦇)理解为一种定时自提示(Self-Prompt)机制。

读到这,我猜你会联想到 AgentGPT 等自动化项目,关于 AgentGPT 提示的缺点,我曾经做过一个小实验:m.okjike.com

(时间有限先写到这里……)

📌 Prompt 模版:「KFCV50 思考法则🐶」(思维定势的影响)

ChatGPT 能够写的文章创新度不够高,又或者说 ChatGPT 只能够得到已经获得的知识而不能够获得崭新的知识。真的是这样的吗?

其实是输入的通道太少。多模态获得的其他感官信息可以暂且不提,哪怕是文字也是如此之少。也因此让 ChatGPT 等对话 AI 缺乏了很多「自我调试」或者「延展思考」的机会。

正如 Manolis 所说:「说实话,我不知道什么是正确的,但让我问一下我的虚拟X,你会怎么做?虚拟 X 会说:要善良。我就会想到:是的!(或者类似的话)。即使我自己可能无法自发地做到这一点,但我最喜欢的提示(Prompt)是逐步思考。这也适用于我的10岁儿子。当他试图一步解决一个数学方程时,我知道他会犯什么错误,但如果我提示(Prompt)他:请逐步思考,那么他就会进入一种思维方式。」

我们每个人的心里面都有一个几乎随时都在待命的 Virtual X。写作的时候,我们拥有无数次逐一调整某句话的机会,在心里不断 Self-Prompt 自己:

🤔 让我检查一下这句话通顺吗?

🤔 它的表达是否有善合理?

🤔 它的逻辑是否圆融?

诸如此类……由此可见,AI 的输出限制之一是:response 的机会相比于人类而言简直少太多了。

我们之所以难以察觉这个差异,原因之一是大脑中思考的过程发生得非常自然,以至于我们没有可能还没有意识到就已经发生。

🧠 还记得这条帖子最后引用的多年前的 youtube 用户访谈视频吗?m.okjike.com

💭 想象一下,一个 AI 也可以无忧无虑地思考……在信号与系统这门课里可以看到,没有输入自然是没办法凭空诞生输出的。毕竟,连预定义的系统也是输入。

如果一句提问(Prompt)对应一句输出,那为什么人可以有多个输出呢?原因就在于各种来源的信号输入。比如大脑里的联想,唤醒记忆,给系统输入视觉信息、文字信息等等。

假如容貌就是硬件外的 UI(用户操作界面),那么还有很多在秘密执行的 Self-Prompt 藏在可见面的背后,并喋喋不休地生产和执行着。

👇 举一个最简单的例子,只有一步自提示的例子

🧪 已知条件:在使用 AI 之前让它首先扮演某个角色,得到的效果有可能好很多。

🤔️ 我们可以怎么做呢?需要去背诵 1000 个「你是一个 xxx,你很擅长 xxx」这样的模版吗?

未必需要(一开始起步玩 AI 还是可以的)

按照我的操作步骤:

1⃣️ 第一步直接输入问题

2⃣️ 第二步让 AI 首先思考哪个职业的人最容易解决这个问题,他们具备什么特质等属性(这只是最容易想到的框架),并站在这个角度去思考就可以了。

换句话说,第二步在用户可见面的背后,就如同食客只需要看见桌上的菜,而不需要看见厨师做饭的厨房内部。

☝️ 同理,那种框架大致类似于一个单词被拆为多个字母,每个字母有不同的意思的「思考法则」,其实道理也是如此。

之前我做了一个「实验」,链接在这里:m.okjike.com

这个实验一是看看 AI 实际是否真的产出更好的内容,二是看看有多少人愿意信。

(其实很多人喜欢屯 Prompt 库已经能说明第二点了。我的观点是记忆一些常用的,剩下的都是靠提问的思维去进行针对化地提问)

只要我想,我就能乱编 9999999999999 个自圆其说的框架收纳到运营资料库。所以当你看到一些资料库,那它有可能是宝藏库,也可能是垃圾堆。比如👇

不信我们来现编一个:KFCV50思考法则

🍗 请看图 1

看我之后我觉得 —— 合情合理(笑)🤪 有些荒谬和幽默感,这也许就是大众短期甚至很长一段时间都难改变的「思维定势」…不是所有看起来像公式的公式就是有用的…

所以,我们才要奋力学会「思辨」m.okjike.com

好了,回到「自提示」这个话题上来。也要想到 DMN 模式 m.okjike.com

我这里可以粗略地把它(蝙蝠🦇)理解为一种定时自提示(Self-Prompt)机制。

读到这,我猜你会联想到 AgentGPT 等自动化项目,关于 AgentGPT 提示的缺点,我曾经做过一个小实验:m.okjike.com

(时间有限先写到这里……)

24 410

来自圈子

AI探索站

105702人已经加入