即刻App年轻人的同好社区

下载

分享一下《生命3.0》的阅读笔记。

作者是物理学家 迈克斯·泰格马克,他也是呼吁停止6个月AI训练公开信的发起人,最近还上过Lex的播客。

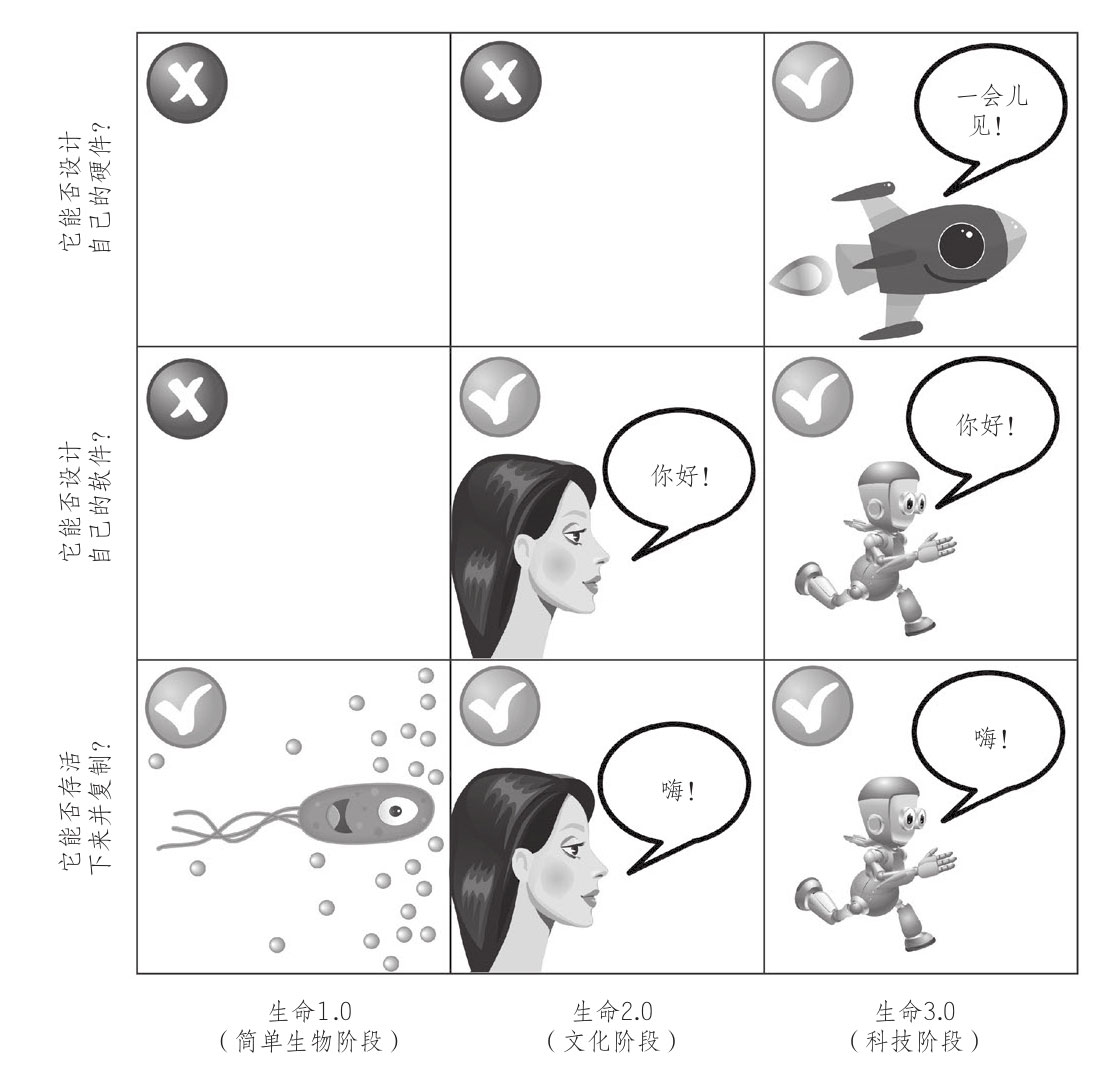

「生命3.0」指的就是可以自己设计硬件和软件的生命,可以理解为很厉害的AI。(图1)

生命1.0,如细菌,个体无法改变身体硬件,也无法进行学习,不能更新软件,它们的学习发生在不同代际,由自然选择保留下有利于生存的变异。生命2.0,如人类,无法改变身体的硬件,但是可以不断学习,更新软件。

---

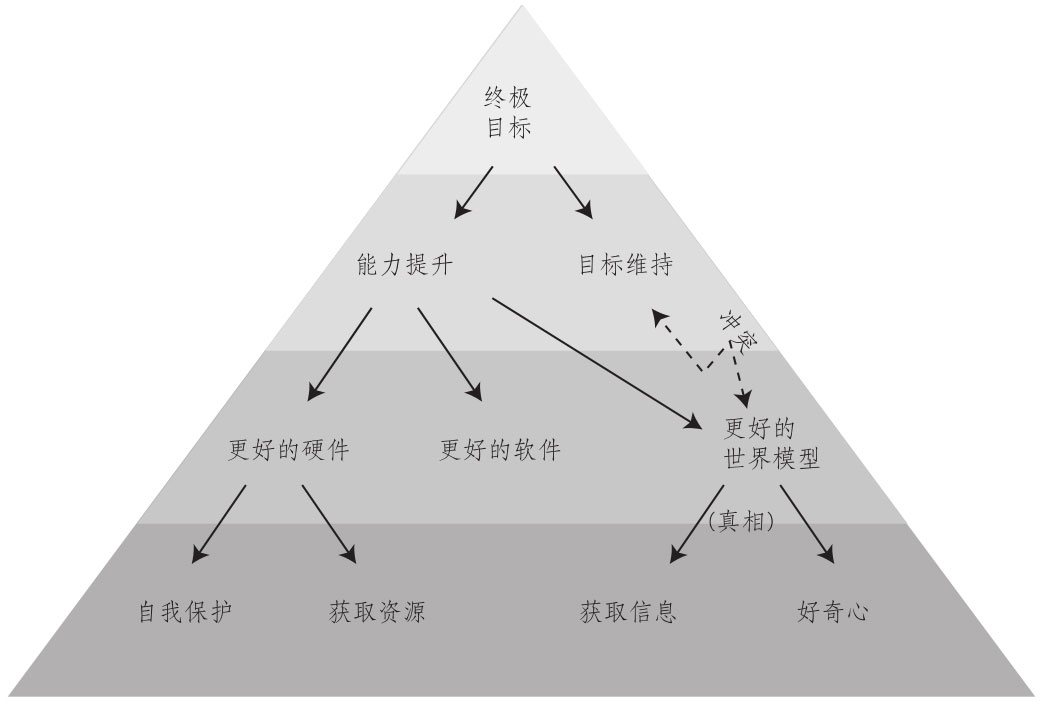

作者指出物质是可以拥有「智能」的,这是由于「记忆」「计算」「学习」是可以独立于物质存在的,不需要人脑就能实现。

物理学并没有一条定律规定只有人类可以拥有智能。在今天的计算机和ChatGPT面前,这已不必多加说明了。

「计算」可以发生在现代的计算机中,也能发生在元胞自动机里。「学习」可以通过神经网络实现。

有些研究者认为,要实现AGI就必须模拟人脑。作者则认为不必。

就像要制造飞行的机器,无需完全模仿鸟类煽动翅膀,机械鸟是一件难度很大的事情。相反,我们可以制造飞机,只要有一定的速度,笨重的钢铁借助空气动力学就能飞起来。

自然选择进化出来的鸟类,其身体机能要考虑繁衍和生存,要羽毛保暖,飞行时也需要节能。而设计飞机就不需要考虑这么多了,不节能无非就是多燃烧一些油。

让ChatGPT产生智能,只需要以预测下一个词作为目标,再“无脑”地喂大量数据,就行了,比大脑简单得多。

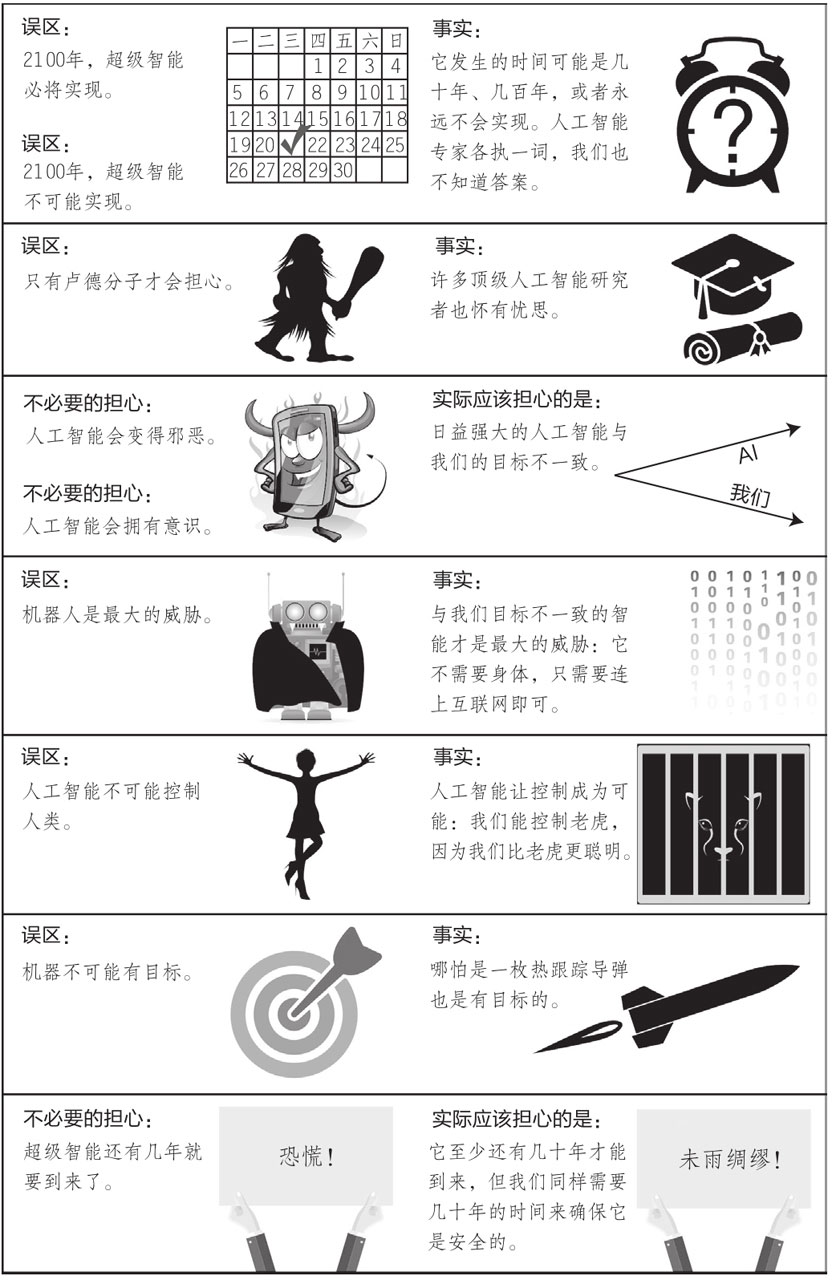

作者在Lex播客中解释喊停AI的原因,不是因为害怕GPT-4本身,GPT-4只是婴儿时期的AGI,没有什么危害。但是GPT-4展示了机器获得智能是多么简单的一件事,实现AGI的时间似乎比之前预测的时间提前了。而人类还没有提出可靠的对齐方式。

同样的,「意识」也可能是独立于物质的,作者认为:意识是信息以某些复杂的方式进行处理时产生的感觉。是处理信息时涌现出来的结果。

(关于意识的定义和实现有比较多的争议,作者把意识定义为一种主观体验的能力)

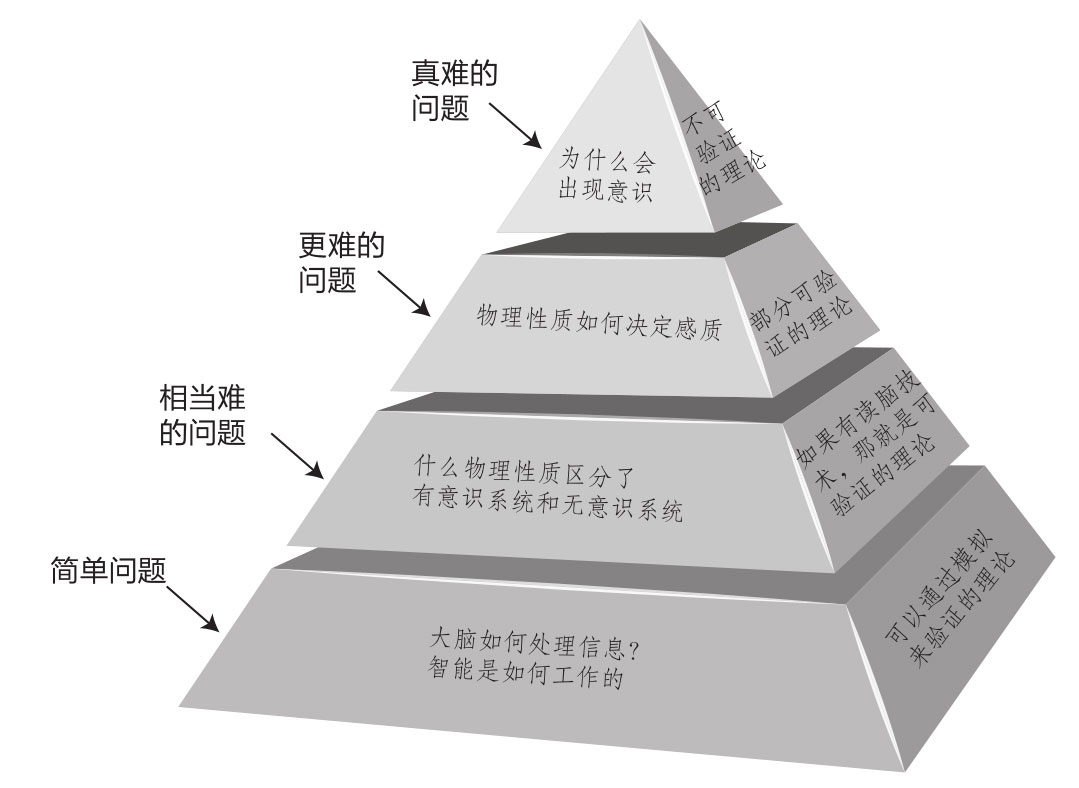

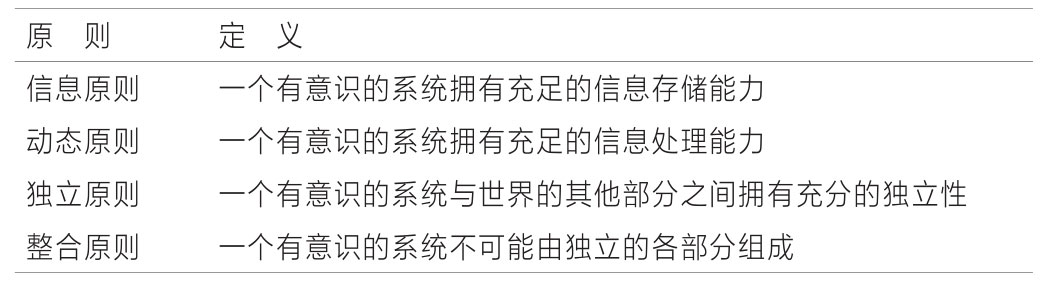

于是,AI也能够拥有「意识」,这点也没有违背物理学。(图3-4)

---

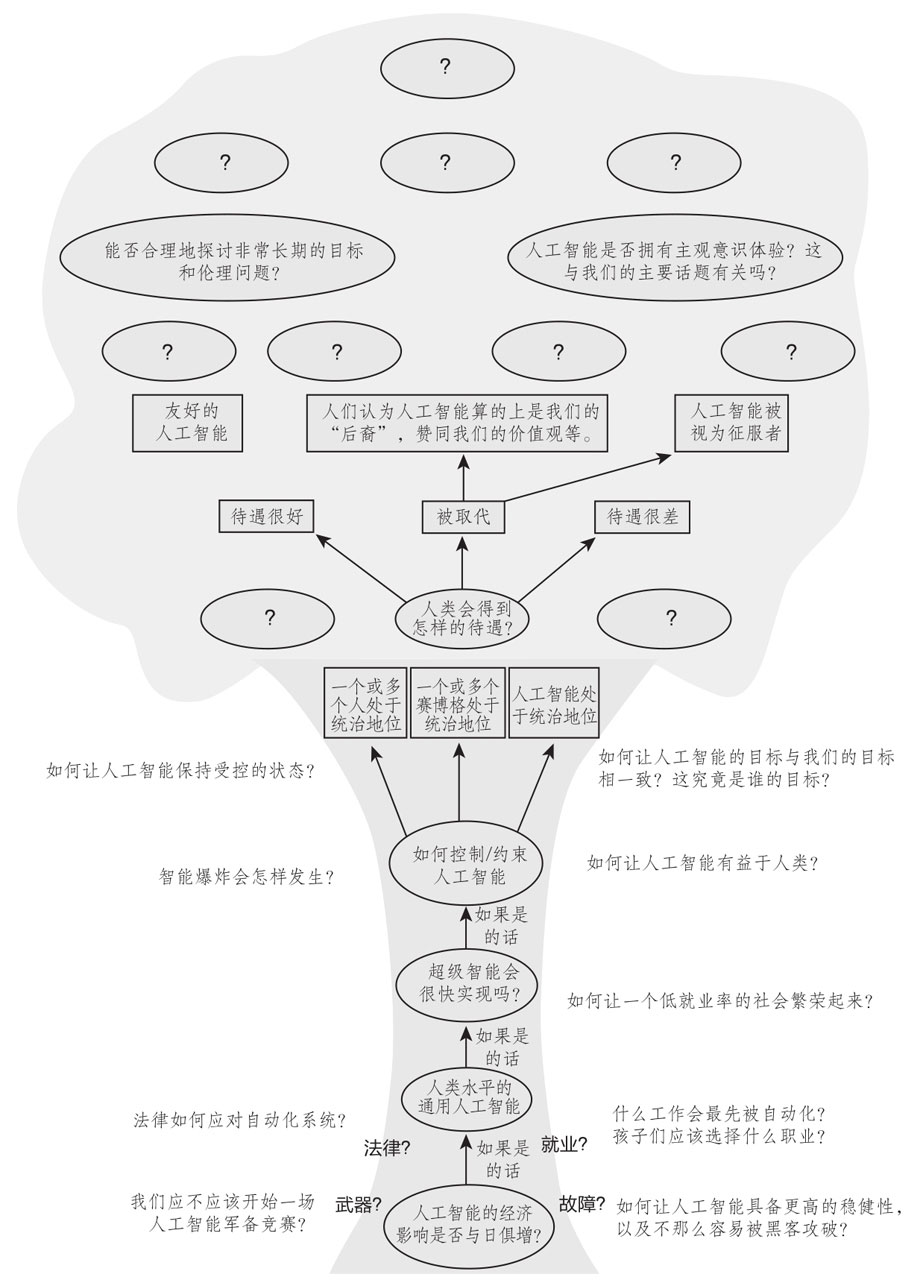

对于超级人工智能对人类会造成什么影响这个问题,作者认为这个问题本身有问题。

「因为它是在被动地询问“会发生什么”,就好像未来已经注定好了一样,而这是错误的!如果一个高级外星科技文明明天就会抵达地球,那么此时,问它们的宇宙飞船抵达时“会发生什么”才是合适的,因为它们的力量可能远远超过我们,所以我们无法对结果产生任何影响。

然而,如果一个由人工智能驱动的高级科技文明即将到来,而人类正是它的缔造者,那么,人类对结果具有很大的影响力,这个影响是在我们创造这个人工智能的过程中潜移默化地加诸其上的。所以我们应该问:“应该发生什么?我们想要什么样的未来?”」

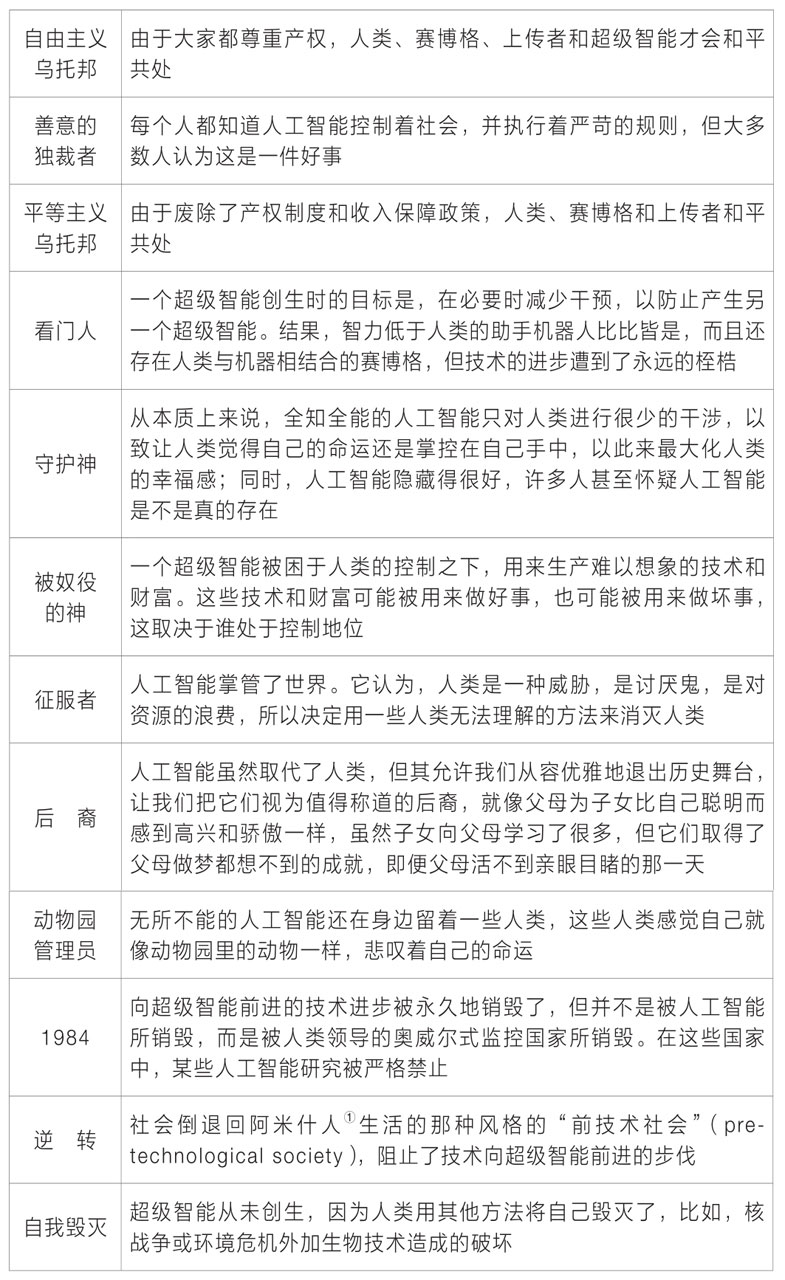

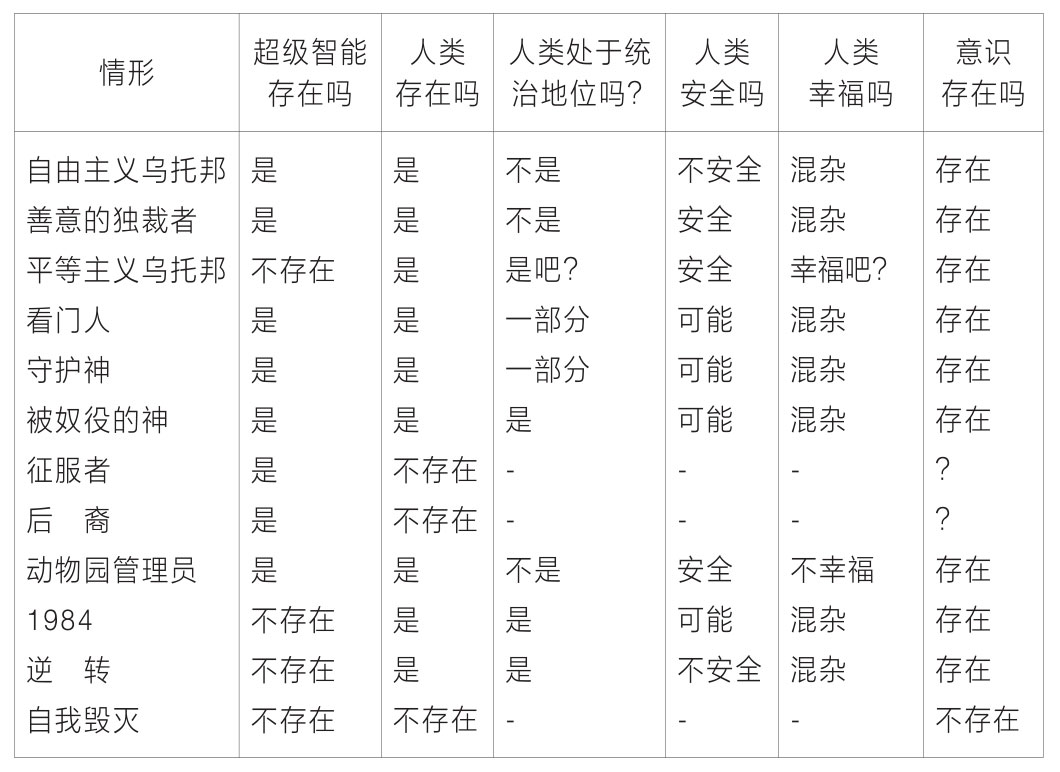

于是作者提供了一些假想的场景,见图5-6。

「超级智能可能与人类和平共处的原因有两种,要么它们是被迫这么做,即“被奴役的神”情景,要么它是发自内心想要与人类和平共处的“友好的人工智能”,也就是“自由主义乌托邦”“守护神”“善意的独裁者”和“动物园管理员”情景。

超级智能也可能不会出现,原因可能有几种:可能是被人工智能(“守门人”情景)或人类(“1984”情景)阻止了,也可能是因为人们选择刻意遗忘技术(“逆转”情景)或失去了建造它的动机(“平等主义乌托邦”情景)。

人类可能会走向灭绝,并被人工智能取代(“征服者”或“后裔”情景),也可能什么都不剩下(“自我毁灭”情景)。」

回答了这个问题,才能引导我们应该怎么设计AI。是否要避免AI产生意识?是否要把AI从盒子里放出来。当然,在这个问题上,恐怕人类是达不成共识的。

---

如果在一年前读这本书,我无疑会当成科幻书来读,可是GPT-4的出现,让我开始认真思考超级人工智能出现的可能,甚至会在头脑里想象AI毁灭人类的场景。

了解了作者和其他AI安全的研究者的观点后,会发现他们并不是杞人忧天,而是有着合理的推理。

过去,研究人员曾告诫不要让AI学习的事:

1. 不要让它们学习编程,那会让它们学会改变自己的程序。

2. 不要让它们上网,那会让它们逃跑。

3. 不要让它们学习人类的偏见,不要让它们看丹尼尔卡尔曼,因为它会懂得如何学会操控人类。

然后我们有了聊天机器人。

作者是物理学家 迈克斯·泰格马克,他也是呼吁停止6个月AI训练公开信的发起人,最近还上过Lex的播客。

「生命3.0」指的就是可以自己设计硬件和软件的生命,可以理解为很厉害的AI。(图1)

生命1.0,如细菌,个体无法改变身体硬件,也无法进行学习,不能更新软件,它们的学习发生在不同代际,由自然选择保留下有利于生存的变异。生命2.0,如人类,无法改变身体的硬件,但是可以不断学习,更新软件。

---

作者指出物质是可以拥有「智能」的,这是由于「记忆」「计算」「学习」是可以独立于物质存在的,不需要人脑就能实现。

物理学并没有一条定律规定只有人类可以拥有智能。在今天的计算机和ChatGPT面前,这已不必多加说明了。

「计算」可以发生在现代的计算机中,也能发生在元胞自动机里。「学习」可以通过神经网络实现。

有些研究者认为,要实现AGI就必须模拟人脑。作者则认为不必。

就像要制造飞行的机器,无需完全模仿鸟类煽动翅膀,机械鸟是一件难度很大的事情。相反,我们可以制造飞机,只要有一定的速度,笨重的钢铁借助空气动力学就能飞起来。

自然选择进化出来的鸟类,其身体机能要考虑繁衍和生存,要羽毛保暖,飞行时也需要节能。而设计飞机就不需要考虑这么多了,不节能无非就是多燃烧一些油。

让ChatGPT产生智能,只需要以预测下一个词作为目标,再“无脑”地喂大量数据,就行了,比大脑简单得多。

作者在Lex播客中解释喊停AI的原因,不是因为害怕GPT-4本身,GPT-4只是婴儿时期的AGI,没有什么危害。但是GPT-4展示了机器获得智能是多么简单的一件事,实现AGI的时间似乎比之前预测的时间提前了。而人类还没有提出可靠的对齐方式。

同样的,「意识」也可能是独立于物质的,作者认为:意识是信息以某些复杂的方式进行处理时产生的感觉。是处理信息时涌现出来的结果。

(关于意识的定义和实现有比较多的争议,作者把意识定义为一种主观体验的能力)

于是,AI也能够拥有「意识」,这点也没有违背物理学。(图3-4)

---

对于超级人工智能对人类会造成什么影响这个问题,作者认为这个问题本身有问题。

「因为它是在被动地询问“会发生什么”,就好像未来已经注定好了一样,而这是错误的!如果一个高级外星科技文明明天就会抵达地球,那么此时,问它们的宇宙飞船抵达时“会发生什么”才是合适的,因为它们的力量可能远远超过我们,所以我们无法对结果产生任何影响。

然而,如果一个由人工智能驱动的高级科技文明即将到来,而人类正是它的缔造者,那么,人类对结果具有很大的影响力,这个影响是在我们创造这个人工智能的过程中潜移默化地加诸其上的。所以我们应该问:“应该发生什么?我们想要什么样的未来?”」

于是作者提供了一些假想的场景,见图5-6。

「超级智能可能与人类和平共处的原因有两种,要么它们是被迫这么做,即“被奴役的神”情景,要么它是发自内心想要与人类和平共处的“友好的人工智能”,也就是“自由主义乌托邦”“守护神”“善意的独裁者”和“动物园管理员”情景。

超级智能也可能不会出现,原因可能有几种:可能是被人工智能(“守门人”情景)或人类(“1984”情景)阻止了,也可能是因为人们选择刻意遗忘技术(“逆转”情景)或失去了建造它的动机(“平等主义乌托邦”情景)。

人类可能会走向灭绝,并被人工智能取代(“征服者”或“后裔”情景),也可能什么都不剩下(“自我毁灭”情景)。」

回答了这个问题,才能引导我们应该怎么设计AI。是否要避免AI产生意识?是否要把AI从盒子里放出来。当然,在这个问题上,恐怕人类是达不成共识的。

---

如果在一年前读这本书,我无疑会当成科幻书来读,可是GPT-4的出现,让我开始认真思考超级人工智能出现的可能,甚至会在头脑里想象AI毁灭人类的场景。

了解了作者和其他AI安全的研究者的观点后,会发现他们并不是杞人忧天,而是有着合理的推理。

过去,研究人员曾告诫不要让AI学习的事:

1. 不要让它们学习编程,那会让它们学会改变自己的程序。

2. 不要让它们上网,那会让它们逃跑。

3. 不要让它们学习人类的偏见,不要让它们看丹尼尔卡尔曼,因为它会懂得如何学会操控人类。

然后我们有了聊天机器人。

73 1726

来自圈子

AI探索站

77939人已经加入