即刻App年轻人的同好社区

下载

groq.com

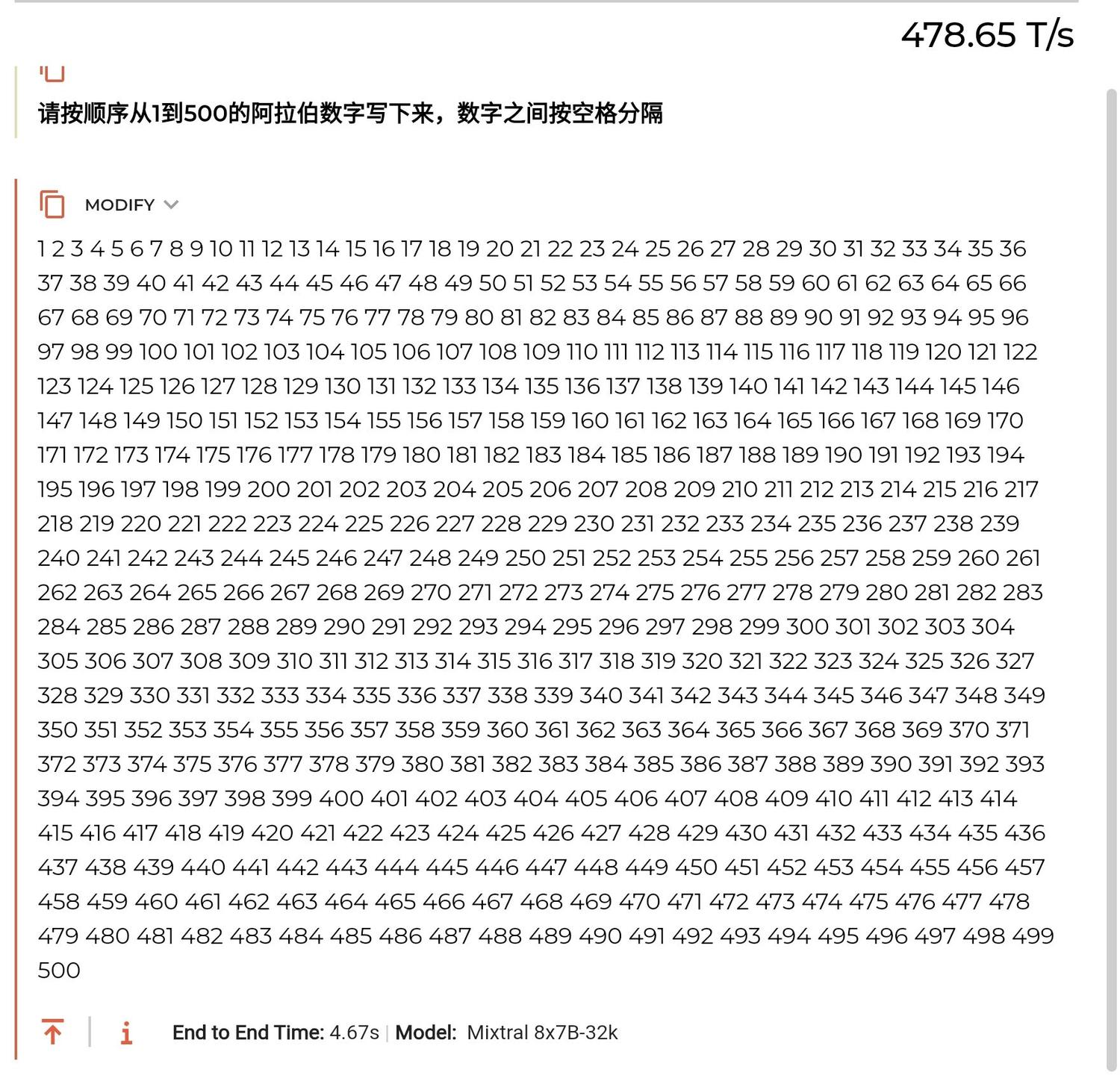

超超超快速的 LLM 推理引擎(gpt推理速度参考,gpt3.5: 70~120T/s,gpt4: 40T/s)

使用 groq LPU 加速的开源模型推理速度达到恐怖的地步,之前看过各种量化裁剪压缩的方法,在 groq 面前都是小打小闹

Llama2 70B-4k(283T/s)

Mixtral 8x7B-32k(479T/s)

超超超快速的 LLM 推理引擎(gpt推理速度参考,gpt3.5: 70~120T/s,gpt4: 40T/s)

使用 groq LPU 加速的开源模型推理速度达到恐怖的地步,之前看过各种量化裁剪压缩的方法,在 groq 面前都是小打小闹

Llama2 70B-4k(283T/s)

Mixtral 8x7B-32k(479T/s)

5 11

假期重新看诺兰的记忆碎片,联想到当前大模型的问题。

片中主角逻辑思维能力很强,但短期记忆的缺失,只能记住几分钟内的事情(上下文有限),记得事故发生前的事情(预训练内化知识),不得不依赖小纸条提示(RAG)去完成任务。要让大模型真正实用,需要有更完善的memory机制。

片中主角逻辑思维能力很强,但短期记忆的缺失,只能记住几分钟内的事情(上下文有限),记得事故发生前的事情(预训练内化知识),不得不依赖小纸条提示(RAG)去完成任务。要让大模型真正实用,需要有更完善的memory机制。

0 00

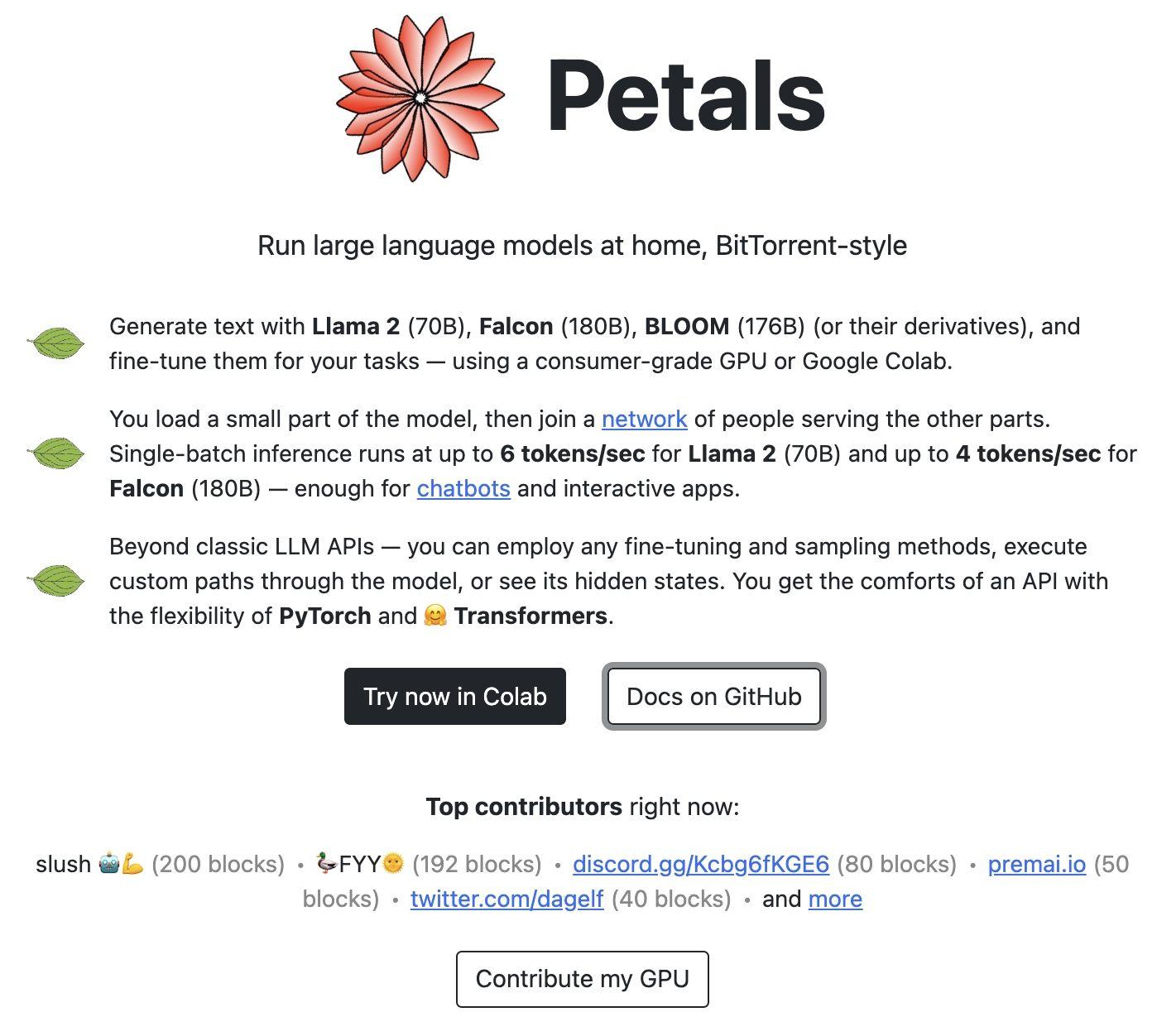

petals.dev 项目通过分布式GPU集群来提供大模型推理能力,大家可以将自己的GPU贡献出去,以一种类似BT协议的方式进行共享推理。

如果能结合web3的奖励机制,感觉发展会更好

如果能结合web3的奖励机制,感觉发展会更好

0 00

今天看到一个项目,就是基于这样的假设,每个智能的员工都是一个智能agent,然后组合来把老板的一句话需求扩展成产品

github.com

github.com

原动态已删除

1 00

大模型的 plugin/function call 类似于智能音箱内置的各种技能槽,同时 LLM 有强大的理解能力和生成能力,通过开放API供开发者使用,有很大的想象空间。

算力和推理速度的提升,未来语音交互会重新焕发光彩,智能音箱、手表、XR这些场景会被重构一遍。

算力和推理速度的提升,未来语音交互会重新焕发光彩,智能音箱、手表、XR这些场景会被重构一遍。

1 00

Let's think step by step 之所以有效,主要还是利用 LLM 本身是语言模型的特点。

而语言模型的这个特点也是导致现阶段LLM的幻觉问题的主要原因,解决幻觉问题潜在的途径:

1. 引入外部知识,看好code interpreter这个方向

2. 让模型学会真正的推理,期待Noam Brown(之前研发了德扑机器人Libratus)加入OpenAI的表现

而语言模型的这个特点也是导致现阶段LLM的幻觉问题的主要原因,解决幻觉问题潜在的途径:

1. 引入外部知识,看好code interpreter这个方向

2. 让模型学会真正的推理,期待Noam Brown(之前研发了德扑机器人Libratus)加入OpenAI的表现

3 00