即刻App年轻人的同好社区

下载

✨大家好~ 我是Simon阿蒙,我现在的身份有:不知道啥时候能毕业的PhD / 佛系自媒体人 / 菜鸟独立开发者 / 断更艺术创作者 / 半个数字游民 / 初创公司打杂人员🐶

👉个人独立站:shengyu.me

✨想成为理解AI,但AI无法取代之人

📑我分享过的有用资源📑:

- 🌟科普教程:

- 我上 AI 顶会啦!CVPR AI Art Gallery 作品极简创作教程 (2024.06): mp.weixin.qq.com

- OpenAI Sora视频生成模型技术报告中英全文+总结+影响分析 (2024.02): mp.weixin.qq.com

- 送立体动态新年红包+最好用的SD客户端+开源视频生成模型 (2024.02): mp.weixin.qq.com

- AI时代抗焦虑指北 —— 被AI包围之后,人类“完蛋”了吗?(2023.12):mp.weixin.qq.com

- AI生成3D问题的简化和解决,以及随之而来的新问题(2023.11):mp.weixin.qq.com

- 如何制造大语言模型的意识幻觉?斯坦福AI小镇论文精读 (2023.09):mp.weixin.qq.com

- ChatGPT基本原理(告诉你为啥它啥都懂)(2023.04):mp.weixin.qq.com

- 从用手建模到用嘴建模:一文说透最新用文字生成三维模型的人工智能算法原理 (2022.10):mp.weixin.qq.com

- 5分钟上手人工智能设计:借AI之力用文字生成图片(无软硬件+前置知识要求,2021.08):mp.weixin.qq.com

- 🌟工具合集:

- 关于声音生成的一切(2024.01):mp.weixin.qq.com

- 关于4D 生成的一切(2024.01):mp.weixin.qq.com

- 关于 chatGPT 的一切(实用工具篇,2023.05):mp.weixin.qq.com

- 关于 ControlNet 的一切(2023.04):mp.weixin.qq.com

- 关于3D 内容人工智能 (AI) 生成的一切(2023.01):mp.weixin.qq.com

- 关于人工智能内容生成(AIGC)的一切(2022.10):mp.weixin.qq.com

😶🌫️

💽AIGC代表作💽:

- 🌟代码开发:

- 我攒了一扇 AI 平行时空传送门——3D gaussian 复杂大场景迁移(2024.04 已暂停):mp.weixin.qq.com

- 我,编程菜鸟,攒了一个用文字生成三维模型的AI工具(Dreamfields-3D,已开源,2022.09):mp.weixin.qq.com

- 🌟艺术商业案例:

- 我如何用AI为小米国际限量版手机做宣传片(2023.03):mp.weixin.qq.com

- AI创作的正确打开方式:雪佛兰×全屏本是×Simon的白日梦 | AIGC商业落地案例复盘 (2023.02):mp.weixin.qq.com

- 国家地理中文网:“守护海洋原住民”系列数字藏品创作(2022.05):mp.weixin.qq.com

- 🌟 AI视频作品:

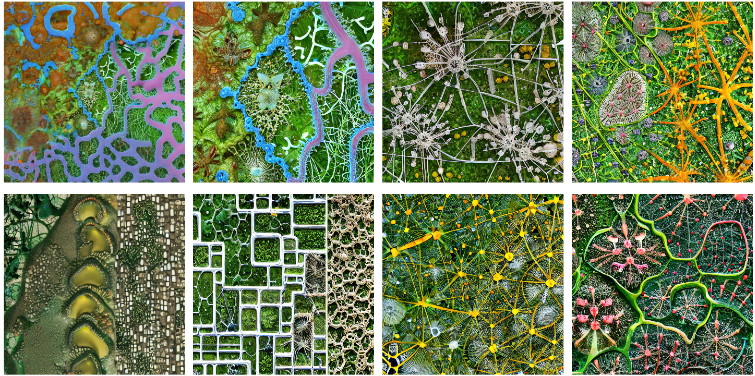

- ✨微观宇宙:一木一浮生,一空一有无, 一念一无限 (2024.08): b23.tv

- 云端画意 —“古董”AI模型生成复古国风山水动画(2023.07):www.bilibili.com

- 硅基生物图鉴-硅藻云戏者(2023.06):www.bilibili.com

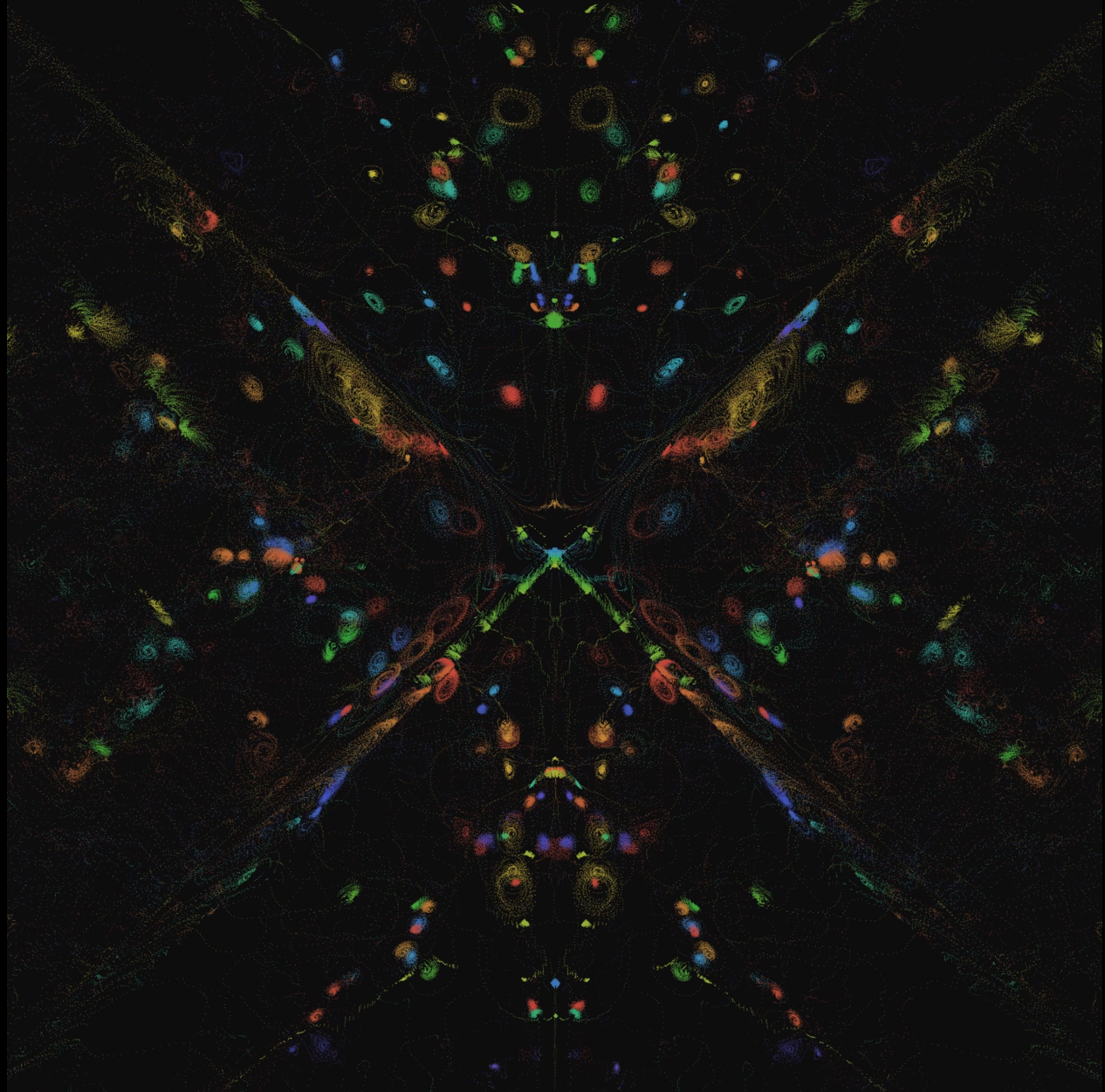

- 量子场-无AI生成艺术(2023.04):www.bilibili.com

- 微观世界极限深潜(2022.10):www.bilibili.com

- 幻时之砂(2021.12):www.bilibili.com

- 超级文明已经组队迁往二次元元宇宙了,而你还没有拿到船票?(2021.12):www.bilibili.com

🎖️AIGC经历🎖️:

- 做过课程或讲座的地方:英国伦敦大学学院 / 奥地利因斯布鲁克大学 / 中央美院 / 小米 / 深圳市插画协会 / 集智俱乐部 / 国际人机交互大会 / 艾厂 / 中国科普作家协会

- 合作过的厂商:小米 / 雪佛兰 / 现代 / 周大福 Tmark / 国家地理中文网

- 参展过的地方:上海设计周 / 上海喜马拉雅美术馆 / 威尼斯元宇宙艺术年展 / 北京Tong画廊 / 郑州海汇美术馆 / 北京-城市建筑双年展 / 伦敦 Zero to One Space / 奥地利-蒂罗尔建筑中心

📻我的社媒📻:

- 公众号 / 视频号 / B站 / 小红书 / 微博:Simon的白日梦

- 我的 AI 自动化创作替身 - CyberGenix:weibo.com

- 知识星球(核心社群):AI白日梦想家 (向我提问,72小时无条件退款,领券:t.zsxq.com)

🥰写在最后🥰:

感谢你读到这里,其实我是一个佛系+拖延的人,能做那么多事情或许真的是因为一直以来大家给我的正反馈,所以我后续会一直在这里更新有用的资源(你可以收藏或者转发这个帖子)。如果你有问题或者希望找我合作,可以私信我也可以发到 📧simondaydream@163.com。如果我48小时后还没有回复,可以再提醒我一次。最后,希望世界和平,愿你身心自在🤗。

👉个人独立站:shengyu.me

✨想成为理解AI,但AI无法取代之人

📑我分享过的有用资源📑:

- 🌟科普教程:

- 我上 AI 顶会啦!CVPR AI Art Gallery 作品极简创作教程 (2024.06): mp.weixin.qq.com

- OpenAI Sora视频生成模型技术报告中英全文+总结+影响分析 (2024.02): mp.weixin.qq.com

- 送立体动态新年红包+最好用的SD客户端+开源视频生成模型 (2024.02): mp.weixin.qq.com

- AI时代抗焦虑指北 —— 被AI包围之后,人类“完蛋”了吗?(2023.12):mp.weixin.qq.com

- AI生成3D问题的简化和解决,以及随之而来的新问题(2023.11):mp.weixin.qq.com

- 如何制造大语言模型的意识幻觉?斯坦福AI小镇论文精读 (2023.09):mp.weixin.qq.com

- ChatGPT基本原理(告诉你为啥它啥都懂)(2023.04):mp.weixin.qq.com

- 从用手建模到用嘴建模:一文说透最新用文字生成三维模型的人工智能算法原理 (2022.10):mp.weixin.qq.com

- 5分钟上手人工智能设计:借AI之力用文字生成图片(无软硬件+前置知识要求,2021.08):mp.weixin.qq.com

- 🌟工具合集:

- 关于声音生成的一切(2024.01):mp.weixin.qq.com

- 关于4D 生成的一切(2024.01):mp.weixin.qq.com

- 关于 chatGPT 的一切(实用工具篇,2023.05):mp.weixin.qq.com

- 关于 ControlNet 的一切(2023.04):mp.weixin.qq.com

- 关于3D 内容人工智能 (AI) 生成的一切(2023.01):mp.weixin.qq.com

- 关于人工智能内容生成(AIGC)的一切(2022.10):mp.weixin.qq.com

😶🌫️

💽AIGC代表作💽:

- 🌟代码开发:

- 我攒了一扇 AI 平行时空传送门——3D gaussian 复杂大场景迁移(2024.04 已暂停):mp.weixin.qq.com

- 我,编程菜鸟,攒了一个用文字生成三维模型的AI工具(Dreamfields-3D,已开源,2022.09):mp.weixin.qq.com

- 🌟艺术商业案例:

- 我如何用AI为小米国际限量版手机做宣传片(2023.03):mp.weixin.qq.com

- AI创作的正确打开方式:雪佛兰×全屏本是×Simon的白日梦 | AIGC商业落地案例复盘 (2023.02):mp.weixin.qq.com

- 国家地理中文网:“守护海洋原住民”系列数字藏品创作(2022.05):mp.weixin.qq.com

- 🌟 AI视频作品:

- ✨微观宇宙:一木一浮生,一空一有无, 一念一无限 (2024.08): b23.tv

- 云端画意 —“古董”AI模型生成复古国风山水动画(2023.07):www.bilibili.com

- 硅基生物图鉴-硅藻云戏者(2023.06):www.bilibili.com

- 量子场-无AI生成艺术(2023.04):www.bilibili.com

- 微观世界极限深潜(2022.10):www.bilibili.com

- 幻时之砂(2021.12):www.bilibili.com

- 超级文明已经组队迁往二次元元宇宙了,而你还没有拿到船票?(2021.12):www.bilibili.com

🎖️AIGC经历🎖️:

- 做过课程或讲座的地方:英国伦敦大学学院 / 奥地利因斯布鲁克大学 / 中央美院 / 小米 / 深圳市插画协会 / 集智俱乐部 / 国际人机交互大会 / 艾厂 / 中国科普作家协会

- 合作过的厂商:小米 / 雪佛兰 / 现代 / 周大福 Tmark / 国家地理中文网

- 参展过的地方:上海设计周 / 上海喜马拉雅美术馆 / 威尼斯元宇宙艺术年展 / 北京Tong画廊 / 郑州海汇美术馆 / 北京-城市建筑双年展 / 伦敦 Zero to One Space / 奥地利-蒂罗尔建筑中心

📻我的社媒📻:

- 公众号 / 视频号 / B站 / 小红书 / 微博:Simon的白日梦

- 我的 AI 自动化创作替身 - CyberGenix:weibo.com

- 知识星球(核心社群):AI白日梦想家 (向我提问,72小时无条件退款,领券:t.zsxq.com)

🥰写在最后🥰:

感谢你读到这里,其实我是一个佛系+拖延的人,能做那么多事情或许真的是因为一直以来大家给我的正反馈,所以我后续会一直在这里更新有用的资源(你可以收藏或者转发这个帖子)。如果你有问题或者希望找我合作,可以私信我也可以发到 📧simondaydream@163.com。如果我48小时后还没有回复,可以再提醒我一次。最后,希望世界和平,愿你身心自在🤗。

62 821

新时代抛弃旧时代的时候,不仅不打招呼,甚至还会把已经在车上的乘客甩下车😂。Adobe公司的股价2024年初达到638美元后,在接下来的两年里下跌了45%,在2026年初至今不到两个月的时间里甚至加速下跌了25%,目前只有260美元出头。因为人们担心AI的图像生成/编辑能力将其完全替代。

但是大家仿佛忘却了,Adobe公司在几年前的GAN/Diffusion时代,还是AI图像生成技术的领导者,发布了多个重要模型和算法,也在很早的时候就将AI图像生成技术融入了Photoshop里面。但是最近一两年的趋势已经变成了多模态统一大模型+生成式Agent。这对Adobe来说太难了,前者要的资源太多,后者则是让他否定自己那么多年的积累的软件范式。

所以,新时代可能不会改进已有的东西,而是把所有东西重做一遍。🥺

但是大家仿佛忘却了,Adobe公司在几年前的GAN/Diffusion时代,还是AI图像生成技术的领导者,发布了多个重要模型和算法,也在很早的时候就将AI图像生成技术融入了Photoshop里面。但是最近一两年的趋势已经变成了多模态统一大模型+生成式Agent。这对Adobe来说太难了,前者要的资源太多,后者则是让他否定自己那么多年的积累的软件范式。

所以,新时代可能不会改进已有的东西,而是把所有东西重做一遍。🥺

7 52

我一般不发暴论,但是玩了几天openclaw🦞之后,越发感觉到打造和你个人context高度耦合的多agent系统是2026的第一场军备竞赛。如果没有打造好,积累经验值的速度相对有系统的人会越来越慢,等级差会逐渐无限扩大。

26 122

发现了一个超好用的gemini增强浏览器插件~!可以给对话分文件夹,一键导出对话,快捷保存prompt,为长对话增加时间线,还能把对话快速备份到google drive🥹!

{Gemini Voyager Official Website + Gemini Voyager (官方主页)}

🧐 这是一个极简风格的官方落地页,通过“思维有形,万物归位”的哲学理念,向用户展示了如何利用可视化时间轴、原生级文件夹管理等功能,将混乱的线性对话重塑为井井有条的知识空间。

➡️链接:voyager.nagi.fun

✨重点

● 🧭 重塑交互哲学

[Philosophy] 网站不仅仅罗列功能,更强调“界面顺应心流”的设计理念。通过时间轴让用户“飞”到思维落点,而非机械滚屏;通过文件夹给思想“安家”,而非任其散落。

● 📂 核心功能展示

[Showcase] 直观展示了三大核心痛点解决方案:

时间轴: 将线性时间转化为可触摸的空间节点。

文件夹: 提供原生手感的拖拽整理体验。

掌控权: 强调数据本地存储,打破云端围墙。

● 🛠️ 效率工具矩阵

[Tools] 除了基础功能,主页还详细列出了实用的辅助工具:

NanoBanana: 无损去除 AI 图片水印。

引用回复: 像聊天软件一样精确引用上下文。

对话宽度: 自由调节窗口宽度,优化代码/表格阅读。

公式复制: 一键提取 LaTeX/MathML 源码。

Mermaid 支持: 将代码块直接渲染为流程图/甘特图。

批量操作: 支持批量删除对话和标签页标题同步。

{Gemini Voyager Official Website + Gemini Voyager (官方主页)}

🧐 这是一个极简风格的官方落地页,通过“思维有形,万物归位”的哲学理念,向用户展示了如何利用可视化时间轴、原生级文件夹管理等功能,将混乱的线性对话重塑为井井有条的知识空间。

➡️链接:voyager.nagi.fun

✨重点

● 🧭 重塑交互哲学

[Philosophy] 网站不仅仅罗列功能,更强调“界面顺应心流”的设计理念。通过时间轴让用户“飞”到思维落点,而非机械滚屏;通过文件夹给思想“安家”,而非任其散落。

● 📂 核心功能展示

[Showcase] 直观展示了三大核心痛点解决方案:

时间轴: 将线性时间转化为可触摸的空间节点。

文件夹: 提供原生手感的拖拽整理体验。

掌控权: 强调数据本地存储,打破云端围墙。

● 🛠️ 效率工具矩阵

[Tools] 除了基础功能,主页还详细列出了实用的辅助工具:

NanoBanana: 无损去除 AI 图片水印。

引用回复: 像聊天软件一样精确引用上下文。

对话宽度: 自由调节窗口宽度,优化代码/表格阅读。

公式复制: 一键提取 LaTeX/MathML 源码。

Mermaid 支持: 将代码块直接渲染为流程图/甘特图。

批量操作: 支持批量删除对话和标签页标题同步。

13 28

推荐大家深读这篇文章,没有感情,全是干货。下面是几个非常触动我的insight:

● 💊 信息碳水理论

类比化肥带来了碳水过剩引发糖尿病,移动互联网带来了信息过剩。未来人类需要像使用“司美格鲁肽”控糖一样,利用 AI 技术来过滤信息、抵御过载,以维持认知健康。

● 📉 资本回报的强制性替代

引用皮凯蒂公式($r > g$),指出资本在周期末端倾向于通过技术替代劳动力来维持高回报。以 OpenAI 为例,其 1.5 万亿美元的潜在估值倒逼出 2030 年需达到 2000 亿美元营收的 KPI,迫使其不得不致力于用 AI (如 Vibe Coding) 替代全球 90% 的程序员市场。

● 🧨 社会结构的“Reset”风险

当前社会总资本与总收入的比重已超过 1914 年(一战前)的峰值。若不反思资本结构,技术进步可能推高资本占比直至引发地缘政治危机或战争等形式的暴力“重启(Reset)”。

张笑宇:AI时代的三个数学等式与人类未来

🧐张笑宇在演讲中用三个核心数学等式解析AI对人类社会的深层影响:“人类当量”揭示AI智力输出成本仅为人类千分之一,将重构社会经济结构;《21世纪资本论》的资本回报率公式指出,资本逐利性可能推动AI优先替代劳动力而非普惠式发展;感官信息与有意识思维的比特差则说明,AI的真正价值在于帮助人类突破认知局限,而非单纯提升信息处理效率。他进一步探讨了AI对情感陪伴、资本结构、认知模式的冲击,提出“信息碳水理论”警示信息过载风险,并展望AI作为认知助手帮助人类寻找意义、构建新型社交关系的未来图景。

➡️链接:mp.weixin.qq.com

✨重点

● 🔢 人类当量公式:大模型智力输出效率是人类的1000倍,成本仅为千分之一,将引发供给侧改革,IP和渠道价值凸显,AI for Science放大顶尖人才能量。

● 💼 资本回报率逻辑:《21世纪资本论》中r>g的规律显示,资本逐利性可能推动AI优先替代劳动力(如90%程序员),而非投入长期科技突破,加剧社会结构失衡。

● 🧠 感官信息差:人类每秒接收10亿比特信息,但有意识思维仅处理10比特,脑机接口难以提升认知效率,AI的价值在于提供洞察而非知识。

● ❤️ 情感陪伴的替代:AI可低成本提供深度情感陪伴(如老年人回忆录),揭示人类情感需求本质上是智力表现的一部分,传统情感关系面临挑战。

● 🔄 社会结构reset:当前资本占社会财富比重已超1914年,若不反思政治经济结构,AI可能引发类似世界大战的reset,需重新组织经济生活方式。

● 📚 独断论天堂风险:AI可构建个性化知识体系(如虚拟雅典学院),但易形成信息茧房,需警惕陷入自满的认知闭环。

● 🍞 信息碳水理论:信息过载如同高碳水饮食,需AI帮助控制信息摄入,抵御推荐算法的负面影响,避免“信息糖尿病”。

● 🔮 AI认知助手:AI可模拟未来自我指导人生抉择,或通过智能眼镜识别信息偏见,帮助人类提升批判性思维,追求智慧而非单纯知识。

● 🤝 新型社交关系:AI时代的社交核心是回归真实连接,通过技术信号(如手环蓝光)打破虚拟隔阂,寻找精神共鸣的灵魂伙伴。

● 🌌 意义的重构:在AI替代重复性劳动的时代,人类的意义不再局限于产出结果,而在于探索多元思维方式、建立深度人际关系与精神连接。

● 💊 信息碳水理论

类比化肥带来了碳水过剩引发糖尿病,移动互联网带来了信息过剩。未来人类需要像使用“司美格鲁肽”控糖一样,利用 AI 技术来过滤信息、抵御过载,以维持认知健康。

● 📉 资本回报的强制性替代

引用皮凯蒂公式($r > g$),指出资本在周期末端倾向于通过技术替代劳动力来维持高回报。以 OpenAI 为例,其 1.5 万亿美元的潜在估值倒逼出 2030 年需达到 2000 亿美元营收的 KPI,迫使其不得不致力于用 AI (如 Vibe Coding) 替代全球 90% 的程序员市场。

● 🧨 社会结构的“Reset”风险

当前社会总资本与总收入的比重已超过 1914 年(一战前)的峰值。若不反思资本结构,技术进步可能推高资本占比直至引发地缘政治危机或战争等形式的暴力“重启(Reset)”。

张笑宇:AI时代的三个数学等式与人类未来

🧐张笑宇在演讲中用三个核心数学等式解析AI对人类社会的深层影响:“人类当量”揭示AI智力输出成本仅为人类千分之一,将重构社会经济结构;《21世纪资本论》的资本回报率公式指出,资本逐利性可能推动AI优先替代劳动力而非普惠式发展;感官信息与有意识思维的比特差则说明,AI的真正价值在于帮助人类突破认知局限,而非单纯提升信息处理效率。他进一步探讨了AI对情感陪伴、资本结构、认知模式的冲击,提出“信息碳水理论”警示信息过载风险,并展望AI作为认知助手帮助人类寻找意义、构建新型社交关系的未来图景。

➡️链接:mp.weixin.qq.com

✨重点

● 🔢 人类当量公式:大模型智力输出效率是人类的1000倍,成本仅为千分之一,将引发供给侧改革,IP和渠道价值凸显,AI for Science放大顶尖人才能量。

● 💼 资本回报率逻辑:《21世纪资本论》中r>g的规律显示,资本逐利性可能推动AI优先替代劳动力(如90%程序员),而非投入长期科技突破,加剧社会结构失衡。

● 🧠 感官信息差:人类每秒接收10亿比特信息,但有意识思维仅处理10比特,脑机接口难以提升认知效率,AI的价值在于提供洞察而非知识。

● ❤️ 情感陪伴的替代:AI可低成本提供深度情感陪伴(如老年人回忆录),揭示人类情感需求本质上是智力表现的一部分,传统情感关系面临挑战。

● 🔄 社会结构reset:当前资本占社会财富比重已超1914年,若不反思政治经济结构,AI可能引发类似世界大战的reset,需重新组织经济生活方式。

● 📚 独断论天堂风险:AI可构建个性化知识体系(如虚拟雅典学院),但易形成信息茧房,需警惕陷入自满的认知闭环。

● 🍞 信息碳水理论:信息过载如同高碳水饮食,需AI帮助控制信息摄入,抵御推荐算法的负面影响,避免“信息糖尿病”。

● 🔮 AI认知助手:AI可模拟未来自我指导人生抉择,或通过智能眼镜识别信息偏见,帮助人类提升批判性思维,追求智慧而非单纯知识。

● 🤝 新型社交关系:AI时代的社交核心是回归真实连接,通过技术信号(如手环蓝光)打破虚拟隔阂,寻找精神共鸣的灵魂伙伴。

● 🌌 意义的重构:在AI替代重复性劳动的时代,人类的意义不再局限于产出结果,而在于探索多元思维方式、建立深度人际关系与精神连接。

6 02

claude code完成后自动弹出通知!太需要了,不用时不时切窗口出来看一下了😂

{Claude Notifications Go: Claude Code Smart Notification Plugin + Claude Code 智能通知插件}

🧐 claude-notifications-go 是一款专为 Claude Code 设计的跨平台智能通知插件。它解决了用户在使用 AI 编写代码时需要一直盯着终端的痛点。当 Claude 完成任务、需要用户确认或遇到错误时,插件会通过桌面弹窗或即时通讯软件(如飞书、Slack)发送通知,让你在多任务处理时不错过任何关键节点。

➡️ 链接:github.com

✨ 重点

🧠 智能状态感知

不仅仅是简单的结束提醒,它能通过状态机分析上下文,精准识别 6 种不同场景:任务完成、代码审查结束、需要回答问题、计划待批准、会话达到上限以及API 认证失效。

📢 多渠道推送支持

桌面端:支持 macOS、Windows 和 Linux 的原生系统通知,且自带专业的提示音效。

移动/协作端:内置 Webhook 支持,可轻松对接 飞书 (Lark)、Slack、Discord、Telegram 以及自定义服务器,实现手机端远程提醒。

⚡ 提升专注力的交互

独有的 macOS "Click-to-focus" 功能:点击桌面通知即可自动激活并将对应的终端窗口(支持 iTerm2, Warp, VS Code 等)置于前台,实现无缝切换。

🛠️ 零依赖极简安装

基于 Go 语言开发,通过 Claude Code 插件系统一键安装。运行 /claude-notifications-go:notifications-init 即可自动下载对应平台的二进制文件,无需手动编译或配置环境。

🎵 高度可定制化

提供交互式配置向导 (notifications-settings),允许用户预览和选择不同的提示音(支持 MP3/WAV/FLAC),调节音量,或自定义 Webhook 的重试策略和格式。

{Claude Notifications Go: Claude Code Smart Notification Plugin + Claude Code 智能通知插件}

🧐 claude-notifications-go 是一款专为 Claude Code 设计的跨平台智能通知插件。它解决了用户在使用 AI 编写代码时需要一直盯着终端的痛点。当 Claude 完成任务、需要用户确认或遇到错误时,插件会通过桌面弹窗或即时通讯软件(如飞书、Slack)发送通知,让你在多任务处理时不错过任何关键节点。

➡️ 链接:github.com

✨ 重点

🧠 智能状态感知

不仅仅是简单的结束提醒,它能通过状态机分析上下文,精准识别 6 种不同场景:任务完成、代码审查结束、需要回答问题、计划待批准、会话达到上限以及API 认证失效。

📢 多渠道推送支持

桌面端:支持 macOS、Windows 和 Linux 的原生系统通知,且自带专业的提示音效。

移动/协作端:内置 Webhook 支持,可轻松对接 飞书 (Lark)、Slack、Discord、Telegram 以及自定义服务器,实现手机端远程提醒。

⚡ 提升专注力的交互

独有的 macOS "Click-to-focus" 功能:点击桌面通知即可自动激活并将对应的终端窗口(支持 iTerm2, Warp, VS Code 等)置于前台,实现无缝切换。

🛠️ 零依赖极简安装

基于 Go 语言开发,通过 Claude Code 插件系统一键安装。运行 /claude-notifications-go:notifications-init 即可自动下载对应平台的二进制文件,无需手动编译或配置环境。

🎵 高度可定制化

提供交互式配置向导 (notifications-settings),允许用户预览和选择不同的提示音(支持 MP3/WAV/FLAC),调节音量,或自定义 Webhook 的重试策略和格式。

23 215

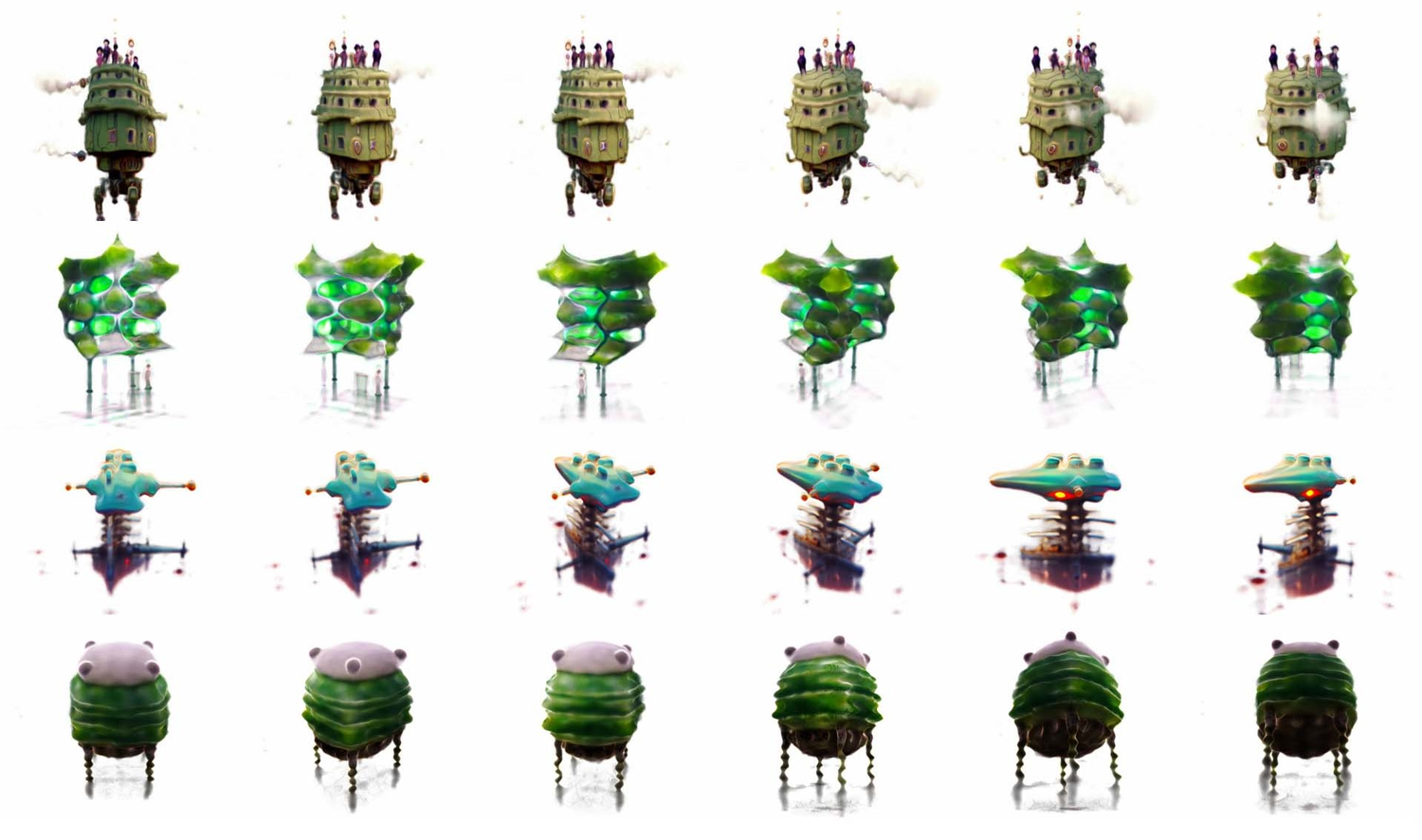

智谱也来搞多模态生成了,这个动作驱动二次元的效果还不错,重新定义三渲二/二渲三🥹

{开源SCAIL海外爆火:260万人围观插画小人,3D骨骼解决动画视频“抽卡”}

🧐清华团队联合GLM大模型开源SCAIL框架,通过3D骨骼姿态表征与全上下文注入机制,实现静态插画/角色的影视级动态化,支持复杂动作迁移与多人互动,海外平台267万次播放验证其娱乐应用价值。

➡️解读链接:mp.weixin.qq.com

➡️代码:github.com

✨重点

●🎨[核心功能] SCAIL让静态角色“活”起来:输入照片+动作指令,即可生成影视级动态效果,X平台插画小人舞蹈还原度超99%,头发/裙子动态跟随自然

●🧠[技术突破] 3D柱体骨骼表征:摒弃传统2D关键点,通过3D关节光栅化编码空间关系,复杂遮挡场景下肢体结构完整度提升47%

●🔄[全上下文注入] DiT架构+Pose-Shifted RoPE:序列维度时空推理,解决ControlNet逐帧控制的全局视野缺失问题,动作连贯性提升38%

●🎬[应用场景] 跨领域拓展:虚拟主播舞蹈、二次元角色动作迁移、多人对战动画、涂鸦艺术动态化(法国艺术家@NebSH作品实现纸上角色跃动)

●👥[多人互动] 端到端多人动作生成:支持单人→双人→任意多人角色互动,国内B站创作者已实现“次元壁打破”的虚拟打斗场景

●🔬[技术优势] 无需复杂训练:通过Progressive Injection渐进式注入控制信号,兼容现有SD/Stable Diffusion等生成模型,部署门槛降低60%

●🌐[生态合作] 法国艺术家@NebSH的涂鸦动画、B站@craftcapitallab的二次元视频流程、海外@grmchn4ai的插画跳舞视频等案例验证实用性

●🚀:支持自定义动作库扩展与角色风格迁移,提供从静态图到动态视频的全流程解决方案

{开源SCAIL海外爆火:260万人围观插画小人,3D骨骼解决动画视频“抽卡”}

🧐清华团队联合GLM大模型开源SCAIL框架,通过3D骨骼姿态表征与全上下文注入机制,实现静态插画/角色的影视级动态化,支持复杂动作迁移与多人互动,海外平台267万次播放验证其娱乐应用价值。

➡️解读链接:mp.weixin.qq.com

➡️代码:github.com

✨重点

●🎨[核心功能] SCAIL让静态角色“活”起来:输入照片+动作指令,即可生成影视级动态效果,X平台插画小人舞蹈还原度超99%,头发/裙子动态跟随自然

●🧠[技术突破] 3D柱体骨骼表征:摒弃传统2D关键点,通过3D关节光栅化编码空间关系,复杂遮挡场景下肢体结构完整度提升47%

●🔄[全上下文注入] DiT架构+Pose-Shifted RoPE:序列维度时空推理,解决ControlNet逐帧控制的全局视野缺失问题,动作连贯性提升38%

●🎬[应用场景] 跨领域拓展:虚拟主播舞蹈、二次元角色动作迁移、多人对战动画、涂鸦艺术动态化(法国艺术家@NebSH作品实现纸上角色跃动)

●👥[多人互动] 端到端多人动作生成:支持单人→双人→任意多人角色互动,国内B站创作者已实现“次元壁打破”的虚拟打斗场景

●🔬[技术优势] 无需复杂训练:通过Progressive Injection渐进式注入控制信号,兼容现有SD/Stable Diffusion等生成模型,部署门槛降低60%

●🌐[生态合作] 法国艺术家@NebSH的涂鸦动画、B站@craftcapitallab的二次元视频流程、海外@grmchn4ai的插画跳舞视频等案例验证实用性

●🚀:支持自定义动作库扩展与角色风格迁移,提供从静态图到动态视频的全流程解决方案

00:04

5 00

那啥,我发现一个比glm更划算的编程套餐,火山引擎出的,只要8.9,还可以切换豆包\GLM\DeepSeek\kimi的旗舰模型,买不了吃亏买不了上当🥹

▶️volcengine.com

✨重点

●💰【价格优势】Lite Plan月费从40元降至9.9元,Pro Plan从200元降至49.9元,支持月付/季付/连续订阅

●🤖【模型支持】Lite Plan支持Doubao、GLM、DeepSeek、Kimi等主流模型,Pro Plan额外提供5倍使用量

●🛠️【工具兼容性】支持Claude Code、Cursor等主流编程工具,可自由选择或自动匹配最优工具

●🚀【核心功能】Doubao-Seed-Code模型优化Agentic任务,支持多模型切换或Auto模式智能选模

●💡【服务保障】24/7客服响应,数据安全保障,支持邀请好友获得折扣

●📚【资源支持】提供技术社区交流群和详细文档,满足开发者技术需求

●🔄【灵活订阅】支持月付、季付等多种周期选择,适合不同使用频率的用户

●🎁【额外福利】Pro Plan用户享有5倍使用量,适合大规模编程需求场景

▶️volcengine.com

✨重点

●💰【价格优势】Lite Plan月费从40元降至9.9元,Pro Plan从200元降至49.9元,支持月付/季付/连续订阅

●🤖【模型支持】Lite Plan支持Doubao、GLM、DeepSeek、Kimi等主流模型,Pro Plan额外提供5倍使用量

●🛠️【工具兼容性】支持Claude Code、Cursor等主流编程工具,可自由选择或自动匹配最优工具

●🚀【核心功能】Doubao-Seed-Code模型优化Agentic任务,支持多模型切换或Auto模式智能选模

●💡【服务保障】24/7客服响应,数据安全保障,支持邀请好友获得折扣

●📚【资源支持】提供技术社区交流群和详细文档,满足开发者技术需求

●🔄【灵活订阅】支持月付、季付等多种周期选择,适合不同使用频率的用户

●🎁【额外福利】Pro Plan用户享有5倍使用量,适合大规模编程需求场景

20 311

2026了,还没折腾明白claude code的同学,我觉得可以直接上open code了~!

🌟划重点:开源、免费、免梯、有客户端界面、有免费模型、无缝自动接入claude skills\MCP,性能接近原生claude code🥹

▶️官网: opencode.ai

具体案例和教程大家可以看@向阳乔木 老师写的这篇科普文:{OpenCode & Oh-My-Opencode + 开源 AI 编程与 Agent 框架}

➡️原文链接:mp.weixin.qq.com

🧐 OpenCode 是一款在 2026 年爆火的开源 AI 编程工具,它不仅提供了类似 Claude Code 的终端交互体验,最核心的突破是解决了封号和高昂费用的痛点。它内置了免费的顶级模型(如 GLM-4.7),并支持通过 Oh-My-Opencode 插件实现多智能体(Agent)协作与 Skill 自动化,极大地降低了 AI 编程的门槛。

✨重点

● 🆓 零成本白嫖顶级模型

OpenCode 内置了强大的免费模型网关,用户无需绑定信用卡即可使用 GLM-4.7。该模型在代码生成(HumanEval 94.2%)和指令遵循(IFEval 88%)方面均表现出色,完美适配 AI 编程场景。

● 🧩 Oh-My-Opencode (OMO) 框架

这是目前最强的 Agent 编排插件。它通过多模型协作,将任务分配给不同的专业 Agent:Sisyphus(主控)、Oracle(架构师)、Librarian(代码库扫描)等,实现复杂任务的自动化处理。

● 🔌 极简的安装与多模型连接

支持 Mac/Windows/Linux,通过一行 curl 命令即可安装。除了内置模型,它还能通过 /connect 轻松集成 GPT、Gemini、Mistral 或本地的 Ollama 模型,提供 75+ 供应商选择。

● 🧠 一句话安装与调用 Skill

兼容 Claude Code 的技术方案。用户只需输入 GitHub 链接即可自动安装 Skill。例如,安装 obsidian-skills 后,只需一句话指令就能生成知识画布文件(Canvas),实现经验的流程化复用。

● 🛠️ 元技能(Skill-Creator)驱动生产力

通过安装官方的 skill-creator,用户可以用自然语言描述工作流来生成自定义 Skill。例如创建一个“前端美化 Skill”,它能自动完成从代码扫描到多方案设计的设计迭代。

● 📁 灵活的 Skill 分享与管理

Skill 的本质是文件夹集合。OpenCode 支持一句话指令完成 Skill 的“打包下载”或通过 GitHub CLI 快速发布分享,方便团队内部的经验传递与流程标准化。

● 🔍 深度集成 MCP 与 联网搜索

内置了 Exa(搜索)、Grep.app(代码海搜)等模型上下文协议(MCP),让 AI 不再局限于训练数据,而是能实时查阅文档、抓取最新的 GitHub 实现或搜索互联网信息。

● 🚀 推荐的明星 Skill 列表

文章推荐了多个实战级 Skill:Superpowers(全能开发包)、Planning-with-files(任务计划管理)、X-article-publisher(自动图文发布)以及 NotebookLM skill(PDF/视频自动总结)。

🌟划重点:开源、免费、免梯、有客户端界面、有免费模型、无缝自动接入claude skills\MCP,性能接近原生claude code🥹

▶️官网: opencode.ai

具体案例和教程大家可以看@向阳乔木 老师写的这篇科普文:{OpenCode & Oh-My-Opencode + 开源 AI 编程与 Agent 框架}

➡️原文链接:mp.weixin.qq.com

🧐 OpenCode 是一款在 2026 年爆火的开源 AI 编程工具,它不仅提供了类似 Claude Code 的终端交互体验,最核心的突破是解决了封号和高昂费用的痛点。它内置了免费的顶级模型(如 GLM-4.7),并支持通过 Oh-My-Opencode 插件实现多智能体(Agent)协作与 Skill 自动化,极大地降低了 AI 编程的门槛。

✨重点

● 🆓 零成本白嫖顶级模型

OpenCode 内置了强大的免费模型网关,用户无需绑定信用卡即可使用 GLM-4.7。该模型在代码生成(HumanEval 94.2%)和指令遵循(IFEval 88%)方面均表现出色,完美适配 AI 编程场景。

● 🧩 Oh-My-Opencode (OMO) 框架

这是目前最强的 Agent 编排插件。它通过多模型协作,将任务分配给不同的专业 Agent:Sisyphus(主控)、Oracle(架构师)、Librarian(代码库扫描)等,实现复杂任务的自动化处理。

● 🔌 极简的安装与多模型连接

支持 Mac/Windows/Linux,通过一行 curl 命令即可安装。除了内置模型,它还能通过 /connect 轻松集成 GPT、Gemini、Mistral 或本地的 Ollama 模型,提供 75+ 供应商选择。

● 🧠 一句话安装与调用 Skill

兼容 Claude Code 的技术方案。用户只需输入 GitHub 链接即可自动安装 Skill。例如,安装 obsidian-skills 后,只需一句话指令就能生成知识画布文件(Canvas),实现经验的流程化复用。

● 🛠️ 元技能(Skill-Creator)驱动生产力

通过安装官方的 skill-creator,用户可以用自然语言描述工作流来生成自定义 Skill。例如创建一个“前端美化 Skill”,它能自动完成从代码扫描到多方案设计的设计迭代。

● 📁 灵活的 Skill 分享与管理

Skill 的本质是文件夹集合。OpenCode 支持一句话指令完成 Skill 的“打包下载”或通过 GitHub CLI 快速发布分享,方便团队内部的经验传递与流程标准化。

● 🔍 深度集成 MCP 与 联网搜索

内置了 Exa(搜索)、Grep.app(代码海搜)等模型上下文协议(MCP),让 AI 不再局限于训练数据,而是能实时查阅文档、抓取最新的 GitHub 实现或搜索互联网信息。

● 🚀 推荐的明星 Skill 列表

文章推荐了多个实战级 Skill:Superpowers(全能开发包)、Planning-with-files(任务计划管理)、X-article-publisher(自动图文发布)以及 NotebookLM skill(PDF/视频自动总结)。

141 7102